###

###

###

###

###

###

###

###

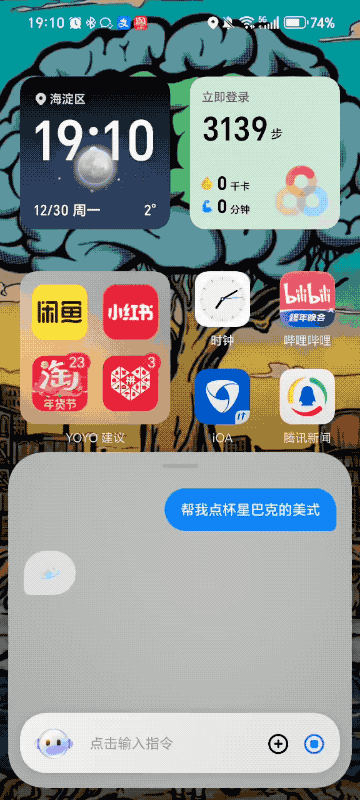

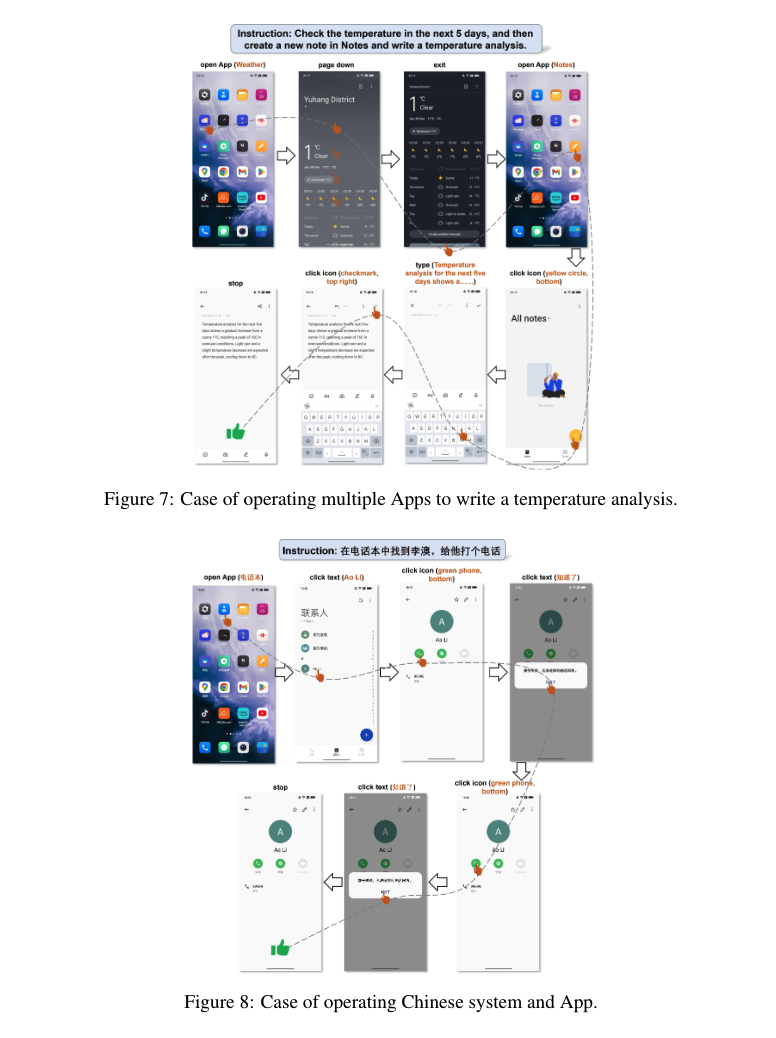

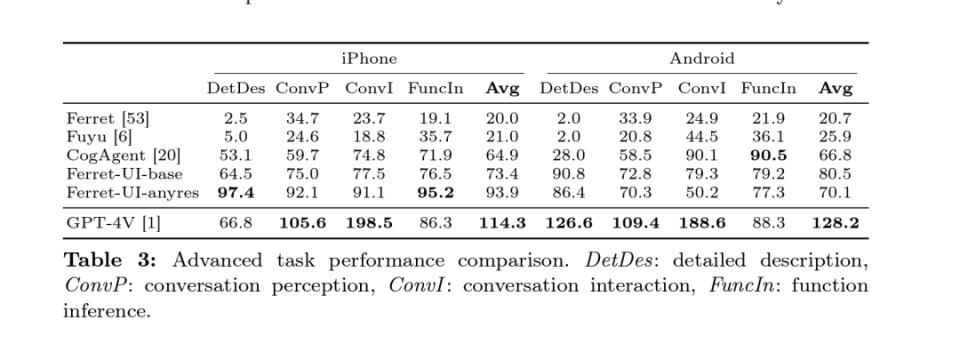

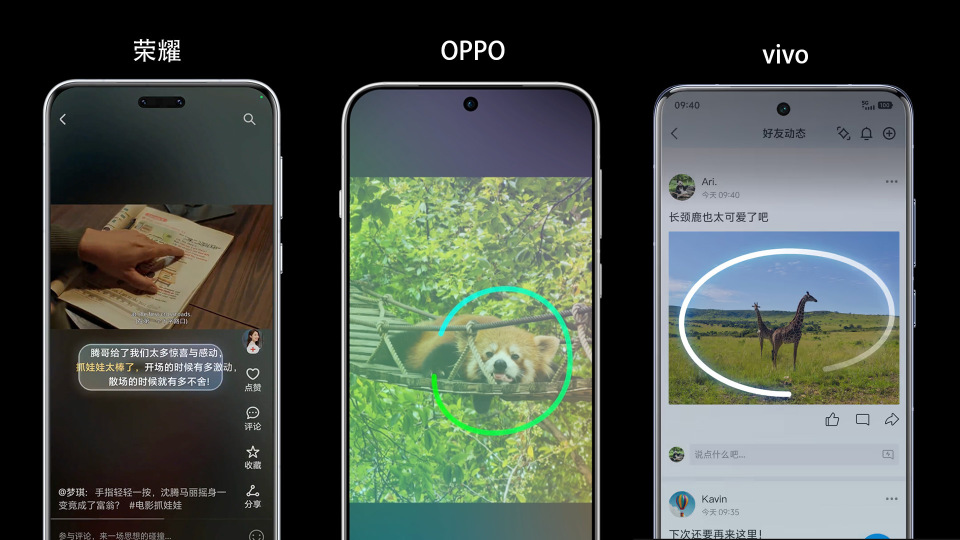

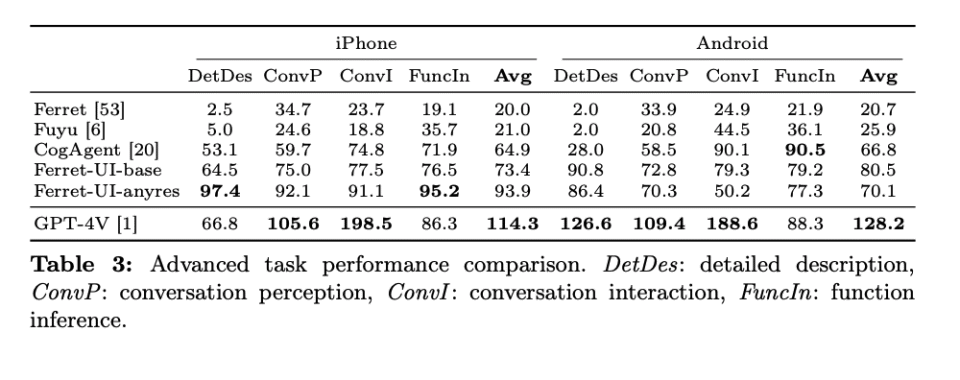

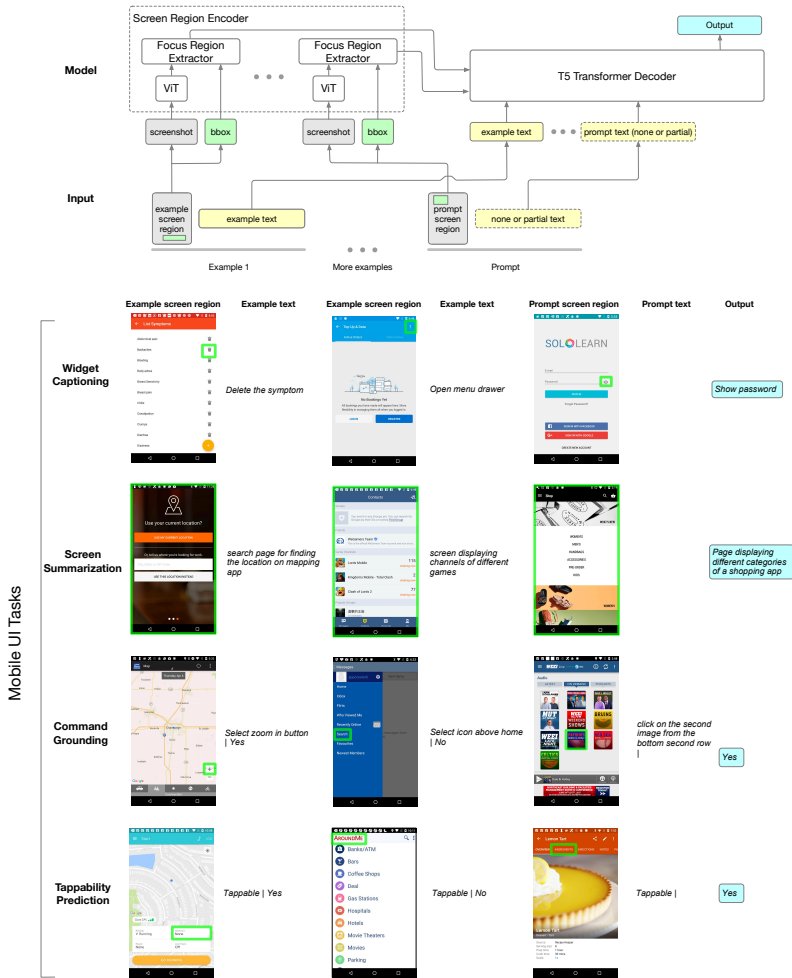

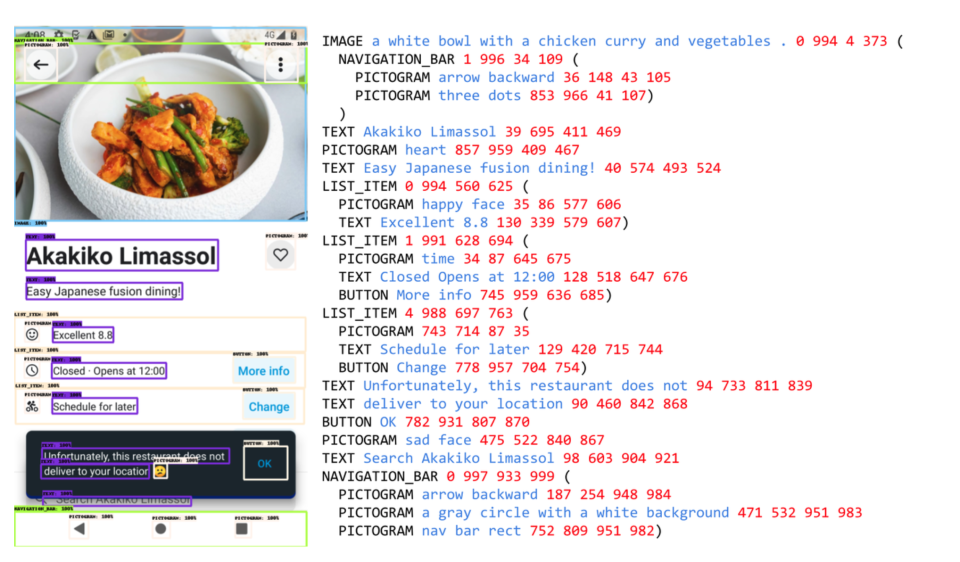

\u003cdiv class="rich_media_content"\u003e\u003cp data-exeditor-arbitrary-box="image-box"\u003e\u003c!--IMG_0--\u003e\u003c/p\u003e\u003cp\u003e腾讯科技《AI未来指北》特约作者 晓静 吴彬\u003c/p\u003e\u003cp\u003e编辑 郑可君\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e对手机厂商来说,AI已经变得越来越重要。\u003c/p\u003e\u003cp\u003e2024年,大多数的手机厂商推出各类AI助手,可以实现一键问屏(手机直接识别屏幕内容)、圈搜(圈出图片中的部分内容并精准搜索)、AI回邮件、AI写会议纪要、AI便签、AI日程管理等功能。\u003c/p\u003e\u003cp\u003e其中, 用AI助手点咖啡是今年较为出圈的功能。\u003c/p\u003e\u003cp\u003e10月14日,荣耀CEO赵明在直播中对着手机中的智能语音助手说:“点三杯美式咖啡”,荣耀手机就自动完成了搜索、下单的操作。周鸿祎坐在一旁直呼:“这个太可怕了。”\u003c/p\u003e\u003cp\u003e同样在10月,vivo也推出了手机智能体”PhoneGPT“,他们向消费者展示的AI功能也是买咖啡。\u003c/p\u003e\u003cp\u003e\u003c!--AIPOS_0--\u003e在这些视频演示中,用户点咖啡一共只需要操作两步:第一是打开手机系统自带的助手,通过语音和文字下达指令;第二是付费下单(主要是输入密码)。\u003c/p\u003e\u003cp\u003e中间的跳转App和下单的过程,并非是AI直接在后台操作。而是AI模拟人类操作手机的全部过程,并在屏幕上显示出每个操作步骤。\u003c/p\u003e\u003cp data-exeditor-arbitrary-box="image-box"\u003e\u003c!--IMG_1--\u003e\u003c/p\u003e\u003cp\u003e\u003cspan style="font-size: 12px"\u003e\u003cspan style="color: rgb(153, 153, 153)"\u003e手机AI助手实现“点咖啡”的过程\u003c/span\u003e\u003c/span\u003e\u003c/p\u003e\u003cp\u003e在11月,大模型明星创业公司智谱AI推出AutoGLM,智谱AI CEO张鹏现场用它发了一个总金额2w的红包,也是只有“下达指令”和“支付红包金额”两个步骤。\u003c/p\u003e\u003cp\u003e发红包和点咖啡一样,都是应用了“大模型视觉理解”的能力,通过识别并手机屏幕上显示的内容来完成操作,就好像模拟人类用户的“点按”操作,而非调用App的API。也就是说,AI完成这些动作并不需要获得第三方App的同意。\u003c/p\u003e\u003cp\u003e因此,AI甚至可以变成一个“虚拟数字用户”,人类用户能做什么,它就能做什么。\u003c/p\u003e\u003cp\u003e\u003cstrong\u003e这似乎能带来无限的想象空间,但也引发了我们的好奇:\u003c/strong\u003e\u003c/p\u003e\u003col classname="ex-list" data-ex-list="ol" data-list-style-type="decimal" style="--ol-list-style-type: decimal"\u003e\u003cli\u003e\u003cp\u003eAI究竟是如何做到仅通过识别屏幕,就可以操作手机的?\u003c/p\u003e\u003c/li\u003e\u003cli\u003e\u003cp\u003e如果在一个普通手机上装一个第三方的大模型App,是不是这个手机就秒变为AI手机?\u003c/p\u003e\u003c/li\u003e\u003cli\u003e\u003cp\u003e如果AI调用App不需要获得App的同意,移动互联网生态将会发生什么改变?\u003c/p\u003e\u003c/li\u003e\u003c/ol\u003e\u003ch4\u003e\u003c!--HPOS_0--\u003e\u003c!--AIPOS_1--\u003e2024年,科技大厂都在努力让AI“看懂”屏幕\u003c/h4\u003e\u003cp\u003e\u003cstrong\u003e先来梳理一下现阶段用AI点咖啡和发红包的流程:\u003c/strong\u003e\u003c/p\u003e\u003cp\u003e1、自然语言理解:用户通过语音或文字向手机助手发出指令;\u003c/p\u003e\u003cp\u003e2、读懂手机界面:手机智能体通过识别手机界面,模拟人类进行点按操作。\u003c/p\u003e\u003cp\u003e3、跨应用协调执行:手机智能体能够在不同应用之间跳转,以完成复杂的多步骤任务。\u003c/p\u003e\u003cp\u003e张鹏在介绍Auto GLM时曾说,“它的应用展现了大模型从对话(Chat)走向操作(Act),从生成式AI(GenAI)迈向代理式AI(Agentic AI)的演进趋势。”\u003c/p\u003e\u003cp\u003e\u003cstrong\u003e这些操作的背后,具体应用了什么关键技术?\u003c/strong\u003e\u003c/p\u003e\u003cp\u003e2023年12月,智谱AI曾发表过一篇论文,名为CogAgent: A Visual Language Model for GUI Agents(《CogAgent:GUI 代理的可视化语言模型》)。\u003c/p\u003e\u003cp\u003e这篇论文提出了CogAgent模型,这是一种专注于GUI理解和导航的180亿参数视觉语言模型。它希望解决的问题是如何让大型视觉语言模型(VLM)更好地理解和导航图形用户界面(GUI),从而提高自动化水平。\u003c/p\u003e\u003cp\u003e可以说,Auto GLM是基于这项研究的产品化体现,让手机、PC等端侧设备,通过视觉语言模型,读懂手机界面,实现多步骤的连续和跨App的操作。\u003c/p\u003e\u003cp\u003e2024年2月,阿里巴巴也曾发布过一篇主题为Mobile- Agent的论文。主要解决如何在移动设备上实现自主的多模态代理,能够通过视觉感知和语义理解完成复杂的操作任务,并自主完成多步任务,且可以跨越多个App。\u003c/p\u003e\u003cp\u003e\u003c!--IMG_2--\u003e\u003cspan style="font-size: 12px"\u003e\u003cspan style="color: rgb(153, 153, 153)"\u003e图:举例Mobile Agent自主打开天气预报软件,并跨越App,完成天气分析报告的过程\u003c/span\u003e\u003c/span\u003e\u003c/p\u003e\u003cp\u003e国外科技巨头也发布过类似的研究成果。2024年4月,苹果发表了一篇论文\u003ci\u003eFerret-UI: Grounded Mobile UI Understanding with Multimodal LLMs(《\u003c/i\u003eFerret-UI: 基于多模态LLMs的移动UI理解模型》),其中介绍了名叫Ferret UI的模型。\u003c/p\u003e\u003cp\u003eFerret UI其实是建立在苹果于2023年10月就已经发布的Ferret模型之上,这个模型仅有7B和13B两个大小,是一个多模态模型。\u003c/p\u003e\u003cp\u003e和动辄上千亿参数规模的主流多模态大模型相比,他们实在是太小了,但是他们的专长是\u003cstrong\u003e识别图像具体区域和定位点\u003c/strong\u003e,这项能力甚至超过了当时最强大的多模态大模型GPT-4V。\u003c/p\u003e\u003cp data-exeditor-arbitrary-box="image-box"\u003e\u003c!--IMG_3--\u003e\u003c/p\u003e\u003cp\u003e苹果 AI / ML 研究科学家 Zhe Gan,当时在X上发布了一条推文称,Ferret可以“在一个图像中的任何地方、任何粒度上引用和定位任何事物”,它还可以使用图像中任何形状的区域来实现这一点。\u003c/p\u003e\u003cp\u003e\u003c!--IMG_4--\u003e\u003cspan style="font-size: 12px"\u003e\u003cspan style="color: rgb(153, 153, 153)"\u003e图:苹果 AI / ML 研究科学家 Zhe Gan的推文\u003c/span\u003e\u003c/span\u003e\u003c/p\u003e\u003cp\u003e通俗来讲,这意味着Ferret模型能够识别图像中指定区域的元素,并将其精确框选。\u003c/p\u003e\u003cp\u003e例如,如果用户在图像中圈出一个物体并询问其种类,Ferret不仅能够识别出该物种,还能理解用户所指的特定动物或植物。讲到这里,是不是立刻就能联想到今年各大手机厂商纷纷推出的“圈搜”功能。\u003c/p\u003e\u003cp\u003e用户可以通过圈选屏幕上的内容,快速获取相关信息,支持跨应用服务,方便用户直接跳转到所需的应用或功能,比如\u003c!--SECURE_LINK_BEGIN_0--\u003e荣耀\u003c!--SECURE_LINK_END_0--\u003e手机支持“一圈即搜”功能的YOYO智能体;vivo提供了“小V圈搜”功能;OPPO的“小布助手”也具备相似的圈选功能。\u003c/p\u003e\u003cp data-exeditor-arbitrary-box="image-box"\u003e\u003c!--IMG_5--\u003e\u003c/p\u003e\u003cp\u003e而Ferret UI模型,就是将Ferret模型的能力应用在手机、PC等端侧交互界面,用户用自然语言下达命令,模型能够直接“读懂”屏幕上的内容——包括App图标、屏幕上的文字。Benchmark测试表明,在iPhone环境下,Ferret UI在初级UI任务中超越了GPT4-V,在包含高级任务的全任务平均得分非常相近,在安卓环境下表现略差。\u003c/p\u003e\u003cp\u003e\u003c!--IMG_6--\u003e\u003cspan style="font-size: 12px"\u003e\u003cspan style="color: rgb(153, 153, 153)"\u003e图:在iPhone环境下,Ferret UI在初级UI任务中超越了GPT4-V,在包含高级任务的全任务平均得分非常相近,在安卓环境下表现略差\u003c/span\u003e\u003c/span\u003e\u003c/p\u003e\u003cp\u003e在2024年10月,苹果又发布了新的Ferret- UI 2模型,这次的升级点主要是跨平台的用户界面(UI)理解,实验结果表明,无论是在iPhone、Android、iPad、Webpage还是AppleTV上,Ferret-UI 2都能有效地理解和响应用户意图,处理高分辨率的UI截图,并在多样化的设备生态系统中无缝扩展。\u003c!--MID_AD_0--\u003e\u003c!--EOP_0--\u003e\u003c/p\u003e\u003c!--MID_ARTICLE_AD_0--\u003e\u003c!--PARAGRAPH_0--\u003e\u003cp\u003e而苹果在操作系统上的最大对手谷歌,甚至更早就曾发布过相关的研究成果。2023年2月24日,谷歌的一篇论文主要提出了Spotlight——一种基于视觉语言的移动端UI理解方法。\u003c/p\u003e\u003cp\u003e它是一个纯视觉的移动UI理解模型,不依赖于视图层次结构数据,而是直接从原始像素中理解UI屏幕。采用了焦点区域抽取器(Focus Region Extractor)和区域总结器(Region Summarizer),使模型能够聚焦于屏幕上的特定区域,并生成基于ViT编码的屏幕区域的潜在表征。\u003c/p\u003e\u003cp\u003e\u003c!--IMG_7--\u003e\u003cspan style="font-size: 12px"\u003e\u003cspan style="color: rgb(153, 153, 153)"\u003e图:谷歌Spotlight模型架构和用户界面任务示例的说明图\u003c/span\u003e\u003c/span\u003e\u003c/p\u003e\u003cp\u003e在3月19日,谷歌又发布了一个新的模型Screen AI,模型的大小还不到5B。它能够识别和理解UI元素和信息图表的内容,包括它们的类型、位置和相互之间的关系,并能生成与屏幕UI元素相关的文本,如问题回答、UI导航指令和内容摘要。\u003c/p\u003e\u003cp\u003e\u003cstrong\u003eSpotlight+Screen AI拼出了谷歌在端侧AI上的技术路线。\u003c/strong\u003e\u003c/p\u003e\u003cp\u003eScreen AI用来理解屏幕上的按钮和文字,而Spotlight专注于屏幕上特定区域的细节,即使只给它看一小部分屏幕截图,也能告诉你那部分是干什么用的。\u003c/p\u003e\u003cp\u003e\u003c!--IMG_8--\u003e\u003cspan style="font-size: 12px"\u003e\u003cspan style="color: rgb(153, 153, 153)"\u003e图:谷歌Screen AI范例——一张带有生成注释的移动应用截图,这些注释包括用户界面元素及其描述,例如,文本(TEXT)元素也包含来自光学字符识别(OCR)的文本内容,图像(IMAGE)元素包含图片说明,列表项(LIST_ITEM)包含它们所有的子元素。\u003c/span\u003e\u003c/span\u003e\u003c/p\u003e\u003cp\u003e2023年10月,谷歌在自己的pixel 8系列手机上也推出了circle to search功能。同时,作为深度绑定的合作伙伴,“圈搜”功能也成为了三星手机AI功能的主打宣传点。\u003c/p\u003e\u003cp\u003e从荣耀、Vivo、智谱AI、阿里,到苹果和谷歌,端侧AI在现阶段的实现路径上似乎达成了一个共识,那就是基于视觉理解大模型的技术基础,让手机直接“看懂”屏幕上的内容,并做出后续的类似于手机智能体的动作。\u003c/p\u003e\u003ch4\u003e\u003c!--HPOS_1--\u003e二、\u003cstrong\u003eAI手机,不是把大模型App装到手机上而已\u003c/strong\u003e\u003c/h4\u003e\u003cp\u003e听起来,想在手机上实现AI功能并不复杂。那么实操过程中,用户体验如何?\u003c/p\u003e\u003cp\u003e腾讯科技深度体验了多个手机“智能体”产品点咖啡或圈搜等功能,基本都是采取以上的技术方案,通过视觉理解大模型的支持,实现多步骤的操作。\u003c/p\u003e\u003cp\u003e现阶段,它们大部分不仅反应速度慢,而在连续执行的过程中经常表现得很像早期的自动驾驶,常常需要人类接管,有时还得重复下指令才能跌跌撞撞地完成任务。\u003c/p\u003e\u003cp\u003e对于一个新手用户而言,体验确实不太友好。\u003c/p\u003e\u003cp\u003e显然,这也无法驱动用户们用真金白银为「AI手机」的概念买单。\u003c/p\u003e\u003cp\u003e另外,即使没有内置AI功能的手机,安装大模型App后也能实现AI相关功能,通过App也能跨应用完成复杂的多步骤任务。\u003c/p\u003e\u003cp\u003e腾讯科技向某个安装了大模型App的普通手机提出了相关需求,它在操作过程中,和内置了大模型App的手机体验差别并不大。\u003c/p\u003e\u003cp\u003e它可以完成比如:帮忙点附近最便宜的全家桶、给某个群里所有人的第一条朋友圈点赞、打开线上会议,加入会议,在会议完成后把纪要发给老板、总结某某公司财报后形成分析报告并通过微信发送给老板等需求。\u003c/p\u003e\u003cp\u003e那么,如果此类大模型应用都可以解决自主操作的问题,那AI手机的优势在哪?目前来看,AI手机时代,「数据」依然是最深的护城河。\u003c/p\u003e\u003cp\u003e手机拥有用户使用手机的本地化数据,具有天然的优势。\u003c/p\u003e\u003cp\u003e\u003cstrong\u003e腾讯科技沟通了多位从业者,不考虑隐私协议,仅从理论层面手机品牌厂商可以获得的用户数据有以下几类:\u003c/strong\u003e\u003c/p\u003e\u003cul classname="ex-list" data-ex-list="ul" data-list-style-type="circle" style="--ul-list-style-type: \u0026#39;\\25EF\u0026#39;" class="nonUnicode-list-style-type"\u003e\u003cli\u003e\u003cp\u003e设备信息:型号、系统、硬件配置(CPU、内存、分辨率)和状态(电量、信号、网络)。\u003c/p\u003e\u003c/li\u003e\u003cli\u003e\u003cp\u003e应用信息:名称、版本、开发者;安装和更新详情;使用情况(启动次数、时长、功能)。\u003c/p\u003e\u003c/li\u003e\u003cli\u003e\u003cp\u003e用户行为:操作记录(点击、滑动、输入);浏览、搜索、下载历史;个人设置(主题、字体、语言)。\u003c/p\u003e\u003c/li\u003e\u003cli\u003e\u003cp\u003e位置信息:当前和历史位置;位置服务使用(导航、地图、搜索)。\u003c/p\u003e\u003c/li\u003e\u003cli\u003e\u003cp\u003e通信记录:通话、短信、邮件。\u003c/p\u003e\u003c/li\u003e\u003cli\u003e\u003cp\u003e网络使用:连接详情(Wi-Fi、蓝牙);流量使用(上网时间、消耗)。\u003c/p\u003e\u003c/li\u003e\u003cli\u003e\u003cp\u003e传感器和环境:传感器数据(加速度计、陀螺仪、摄像头);环境信息(温度、湿度、光线)。\u003c/p\u003e\u003c/li\u003e\u003cli\u003e\u003cp\u003e账户信息:注册、登录信息;账户关联(邮箱、电话、社交账号)。\u003c/p\u003e\u003c/li\u003e\u003c!--MID_AD_1--\u003e\u003c!--EOP_1--\u003e\u003c/ul\u003e\u003c!--MID_ARTICLE_AD_1--\u003e\u003c!--PARAGRAPH_1--\u003e\u003cp\u003e这意味着对于一台手机来说,几乎所有的操作、细致到屏幕上任何一个文字和按钮,\u003cstrong\u003e都可以被“原子化”写入到AI理解的范围内。\u003c/strong\u003e\u003c/p\u003e\u003cp\u003e当这些原子化的数据成规模地出现在手机AI的学习范围内时,它就能够形成一个最初的用户个人知识库。\u003c/p\u003e\u003cp\u003e但是,只以本地化的用户行为数据作为学习范围显然是不够的,智能手机更多的功能延续,要通过各种不同的第三方App实现,这些第三方的数据才能告诉AI智能体,用户到底是爱吃牛肉汉堡还是鸡肉汉堡、喜欢喝冰美式还是热美式。 \u003c/p\u003e\u003cp\u003e所以想要做到真正的意图识别,让手机成为每个人的AI智能体,终究绕不过从需要底层理解用户行为,这需要整个生态的配合。\u003c/p\u003e\u003cp\u003e\u003c!--AIPOS_2--\u003e但是,第三方应用数据的缺失,让手机厂商们没有办法通过API调用去解决AI自主操作的问题,不得已选择屏幕识别这样的技术路线绕过这条数据护城河。手机厂商在用阻力最小的方式先做到让手机变得“更智能”,先让手机上有一个AI,现阶段,它可以帮助用户操作手机且不需要App们同意,算是迈出了第一步。\u003c/p\u003e\u003cp\u003e腾讯科技咨询了一位手机行业资深产品经理,他表示,当下AI手机绕过数据交换确实是不得已而为之的行为。\u003c/p\u003e\u003cp\u003e“\u003cstrong\u003e这个问题的关键是看手机厂商究竟想解决什么问题。如果要解决‘简单调用’的问题,通过 API是可行的,但是这在目前的手机生态中是很难实现的,因为没有App有足够的动力向手机厂商开放API。但是,模拟点击不需要,只要手机在系统级别支持就好了,而手机的操作系统是有动力的,因为大家都想让自己的操作系统变得更智能。\u003c/strong\u003e”\u003c!--MID_AD_2--\u003e\u003c!--EOP_2--\u003e\u003c/p\u003e\u003c!--MID_ARTICLE_AD_2--\u003e\u003c!--PARAGRAPH_2--\u003e\u003ch4\u003e\u003c!--HPOS_2--\u003e三、理想的AI手机体验,是无形的服务\u003c/h4\u003e\u003cp\u003e\u003c!--AIPOS_3--\u003e理想的“AI手机”体验,应该是帮助用户于无形之中。今年行业内用一个词来描述这种体验,叫做“意图识别”。\u003c/p\u003e\u003cp\u003e简单来讲,就是手机、PC等端侧设备能够最穿透用户意识的“迷雾”,做到比用户自己更懂自己的“意图”,手机的Agent(智能体)接收个性化的意图指令,自动帮忙去执行一系列任务。\u003c/p\u003e\u003cp\u003e手机厂商目前通过屏幕识别,“连续点按”App的操作,已经完成了类似于RPA(机器人流程自动化)的过程,但是缺少“记忆”,就是用户散落在各个第三方App中的第三方应用的行为偏好数据。\u003c/p\u003e\u003cp\u003e这并不能从根本上解决数据互通的问题,只是形式上的智能,不是根本的智能。手机还是无法判断用户在具体场景中真正的喜好。\u003c/p\u003e\u003cp\u003e数据的壁垒和生态的难题,真的完全无解吗?\u003c/p\u003e\u003cp\u003e某资深从业者告诉腾讯科技,”目前行业内初步形成了一个比较有共识的解决方案,\u003cstrong\u003e未来,可能每个手机App都会拥有一个独立的Agent,大家所做的是手机系统级别的Agent和应用的各个第三方的Agent握手通信,本地的Agent负责理解用户意图,将脱敏之后的数据传递给第三方的Agent,对方完成之后再返回给手机,以完成用户的需求。\u003c/strong\u003e“\u003c!--MID_AD_3--\u003e\u003c!--EOP_3--\u003e\u003c/p\u003e\u003c!--MID_ARTICLE_AD_3--\u003e\u003c!--PARAGRAPH_3--\u003e\u003cp\u003e就好像每个App派出一个Agent代表,去接收别的App及系统发出的请求——”只反馈请求,不交出数据”,这看起来确实是不错的解决方案。\u003c/p\u003e\u003cp\u003e雏形已成,但是,还有几个问题需要解决:\u003c/p\u003e\u003col classname="ex-list" data-ex-list="ol" data-list-style-type="decimal" style="--ol-list-style-type: decimal"\u003e\u003cli\u003e\u003cp\u003eAgent和Agent之间、手机操作系统和Agent之间,如果没有统一的通信协议和标准,如何真正的“握手”交互和流转?\u003c/p\u003e\u003c/li\u003e\u003cli\u003e\u003cp\u003e大模型采用明文传输,在Agent互相握手传递需求的时候,是不是真的有切实有效的方式保护敏感的个人数据?\u003c/p\u003e\u003c/li\u003e\u003cli\u003e\u003cp\u003e一个系统级别Agent,理应和手机操作系统深度融合,甚至是手机操作系统的一部分,现有的手机操作系统的底层架构,是否能够完美支持这样一个强大的Agent?\u003c/p\u003e\u003c/li\u003e\u003c!--MID_AD_4--\u003e\u003c!--EOP_4--\u003e\u003c/ol\u003e\u003c!--MID_ARTICLE_AD_4--\u003e\u003c!--PARAGRAPH_4--\u003e\u003cp\u003e从表面上看,AI助手让手机操作变得更加便捷;但深入来看,Agent间的通信协议、数据安全传输、系统架构重构等问题,都需要整个行业达成共识。就像互联网需要HTTP协议一样,AI时代的手机生态同样需要建立新的\u0026#34;游戏规则\u0026#34;。\u003c/p\u003e\u003cp\u003e在这场无声的变革中,一个问题值得我们思考:让AI真正走入手机生态,我们是否准备好了?\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e\u003cstrong\u003e参考资料:\u003c/strong\u003e\u003c/p\u003e\u003cp\u003ehttps://x.com/zhegan4/status/1712345137983201716\u003c/p\u003e\u003cp\u003ehttps://research.google/blog/screenai-a-visual-language-model-for-ui-and-visually-situated-language-understanding/\u003c/p\u003e\u003cp\u003ehttps://arxiv.org/pdf/2410.18967v1\u003c/p\u003e\u003cp\u003ehttps://arxiv.org/pdf/2209.14927\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cdiv powered-by="qqnews_ex-editor"\u003e\u003c/div\u003e\u003cstyle\u003e.rich_media_content{--news-tabel-th-night-color: #444444;--news-font-day-color: #333;--news-font-night-color: #d9d9d9;--news-bottom-distance: 22px}.rich_media_content p:not([data-exeditor-arbitrary-box=image-box]){letter-spacing:.5px;line-height:30px;margin-bottom:var(--news-bottom-distance);word-wrap:break-word}.rich_media_content{color:var(--news-font-day-color);font-size:18px}@media(prefers-color-scheme:dark){body:not([data-weui-theme=light]):not([dark-mode-disable=true]) .rich_media_content p:not([data-exeditor-arbitrary-box=image-box]){letter-spacing:.5px;line-height:30px;margin-bottom:var(--news-bottom-distance);word-wrap:break-word}body:not([data-weui-theme=light]):not([dark-mode-disable=true]) .rich_media_content{color:var(--news-font-night-color)}}.data_color_scheme_dark .rich_media_content p:not([data-exeditor-arbitrary-box=image-box]){letter-spacing:.5px;line-height:30px;margin-bottom:var(--news-bottom-distance);word-wrap:break-word}.data_color_scheme_dark .rich_media_content{color:var(--news-font-night-color)}.data_color_scheme_dark .rich_media_content{font-size:18px}.rich_media_content p[data-exeditor-arbitrary-box=image-box]{margin-bottom:11px}.rich_media_content\u003ediv:not(.qnt-video),.rich_media_content\u003esection{margin-bottom:var(--news-bottom-distance)}.rich_media_content hr{margin-bottom:var(--news-bottom-distance)}.rich_media_content .link_list{margin:0;margin-top:20px;min-height:0!important}.rich_media_content blockquote{background:#f9f9f9;border-left:6px solid #ccc;margin:1.5em 10px;padding:.5em 10px}.rich_media_content blockquote p{margin-bottom:0!important}.data_color_scheme_dark .rich_media_content blockquote{background:#323232}@media(prefers-color-scheme:dark){body:not([data-weui-theme=light]):not([dark-mode-disable=true]) .rich_media_content blockquote{background:#323232}}.rich_media_content ol[data-ex-list]{--ol-start: 1;--ol-list-style-type: decimal;list-style-type:none;counter-reset:olCounter calc(var(--ol-start,1) - 1);position:relative}.rich_media_content ol[data-ex-list]\u003eli\u003e:first-child::before{content:counter(olCounter,var(--ol-list-style-type)) '. ';counter-increment:olCounter;font-variant-numeric:tabular-nums;display:inline-block}.rich_media_content ul[data-ex-list]{--ul-list-style-type: circle;list-style-type:none;position:relative}.rich_media_content ul[data-ex-list].nonUnicode-list-style-type\u003eli\u003e:first-child::before{content:var(--ul-list-style-type) ' ';font-variant-numeric:tabular-nums;display:inline-block;transform:scale(0.5)}.rich_media_content ul[data-ex-list].unicode-list-style-type\u003eli\u003e:first-child::before{content:var(--ul-list-style-type) ' ';font-variant-numeric:tabular-nums;display:inline-block;transform:scale(0.8)}.rich_media_content ol:not([data-ex-list]){padding-left:revert}.rich_media_content ul:not([data-ex-list]){padding-left:revert}.rich_media_content table{display:table;border-collapse:collapse;margin-bottom:var(--news-bottom-distance)}.rich_media_content table th,.rich_media_content table td{word-wrap:break-word;border:1px solid #ddd;white-space:nowrap;padding:2px 5px}.rich_media_content table th{font-weight:700;background-color:#f0f0f0;text-align:left}.rich_media_content table p{margin-bottom:0!important}.data_color_scheme_dark .rich_media_content table th{background:var(--news-tabel-th-night-color)}@media(prefers-color-scheme:dark){body:not([data-weui-theme=light]):not([dark-mode-disable=true]) .rich_media_content table th{background:var(--news-tabel-th-night-color)}}.rich_media_content .qqnews_image_desc,.rich_media_content p[type=om-image-desc]{line-height:20px!important;text-align:center!important;font-size:14px!important;color:#666!important}.rich_media_content div[data-exeditor-arbitrary-box=wrap]:not([data-exeditor-arbitrary-box-special-style]){max-width:100%}.rich_media_content .qqnews-content{--wmfont: 0;--wmcolor: transparent;font-size:var(--wmfont);color:var(--wmcolor);line-height:var(--wmfont)!important;margin-bottom:var(--wmfont)!important}.rich_media_content .qqnews_sign_emphasis{background:#f7f7f7}.rich_media_content .qqnews_sign_emphasis ol{word-wrap:break-word;border:none;color:#5c5c5c;line-height:28px;list-style:none;margin:14px 0 6px;padding:16px 15px 4px}.rich_media_content .qqnews_sign_emphasis p{margin-bottom:12px!important}.rich_media_content .qqnews_sign_emphasis ol\u003eli\u003ep{padding-left:30px}.rich_media_content .qqnews_sign_emphasis ol\u003eli{list-style:none}.rich_media_content .qqnews_sign_emphasis ol\u003eli\u003ep:first-child::before{margin-left:-30px;content:counter(olCounter,decimal) ''!important;counter-increment:olCounter!important;font-variant-numeric:tabular-nums!important;background:#37f;border-radius:2px;color:#fff;font-size:15px;font-style:normal;text-align:center;line-height:18px;width:18px;height:18px;margin-right:12px;position:relative;top:-1px}.data_color_scheme_dark .rich_media_content .qqnews_sign_emphasis{background:#262626}.data_color_scheme_dark .rich_media_content .qqnews_sign_emphasis ol\u003eli\u003ep{color:#a9a9a9}@media(prefers-color-scheme:dark){body:not([data-weui-theme=light]):not([dark-mode-disable=true]) .rich_media_content .qqnews_sign_emphasis{background:#262626}body:not([data-weui-theme=light]):not([dark-mode-disable=true]) .rich_media_content .qqnews_sign_emphasis ol\u003eli\u003ep{color:#a9a9a9}}.rich_media_content h1,.rich_media_content h2,.rich_media_content h3,.rich_media_content h4,.rich_media_content h5,.rich_media_content h6{margin-bottom:var(--news-bottom-distance);font-weight:700}.rich_media_content h1{font-size:20px}.rich_media_content h2,.rich_media_content h3{font-size:19px}.rich_media_content h4,.rich_media_content h5,.rich_media_content h6{font-size:18px}.rich_media_content li:empty{display:none}.rich_media_content ul,.rich_media_content ol{margin-bottom:var(--news-bottom-distance)}.rich_media_content div\u003ep:only-child{margin-bottom:0!important}.rich_media_content .cms-cke-widget-title-wrap p{margin-bottom:0!important}\u003c/style\u003e\u003c/div\u003e

本文来自作者[猫巷少女新竹]投稿,不代表蔚蓝之海立场,如若转载,请注明出处:https://foryh.cn/wiki/35731.html

评论列表(4条)

我是蔚蓝之海的签约作者“猫巷少女新竹”!

希望本篇文章《AI操作手机,不需要App同意?这场“越权”的生态暗战才刚开始_腾讯新闻》能对你有所帮助!

本站[蔚蓝之海]内容主要涵盖:生活百科,小常识等内容......

本文概览:######################## \u003cdiv class="rich_media_content"\u003e\u003cp data-exeditor...