###

###

###

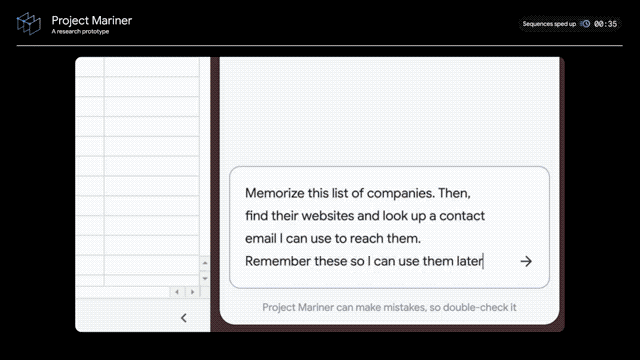

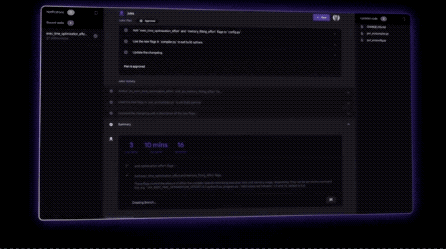

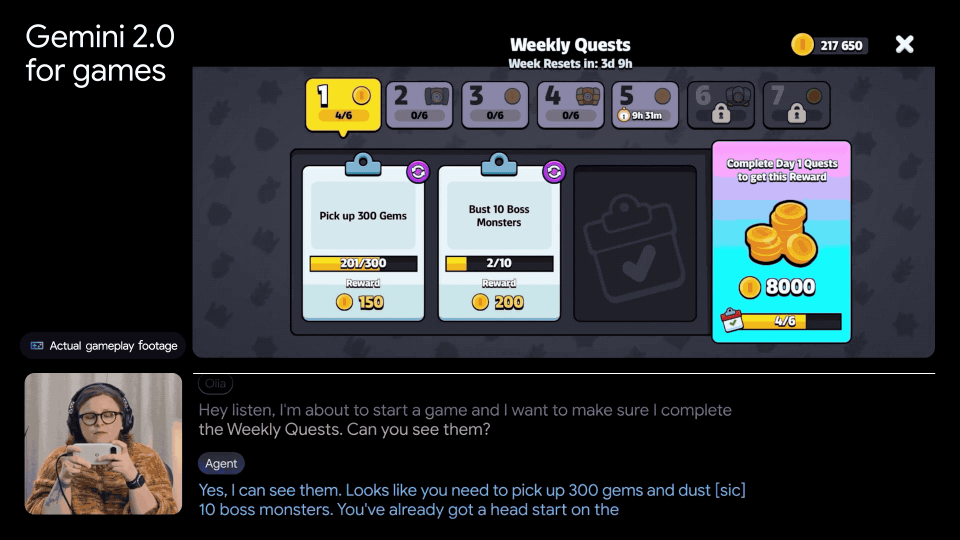

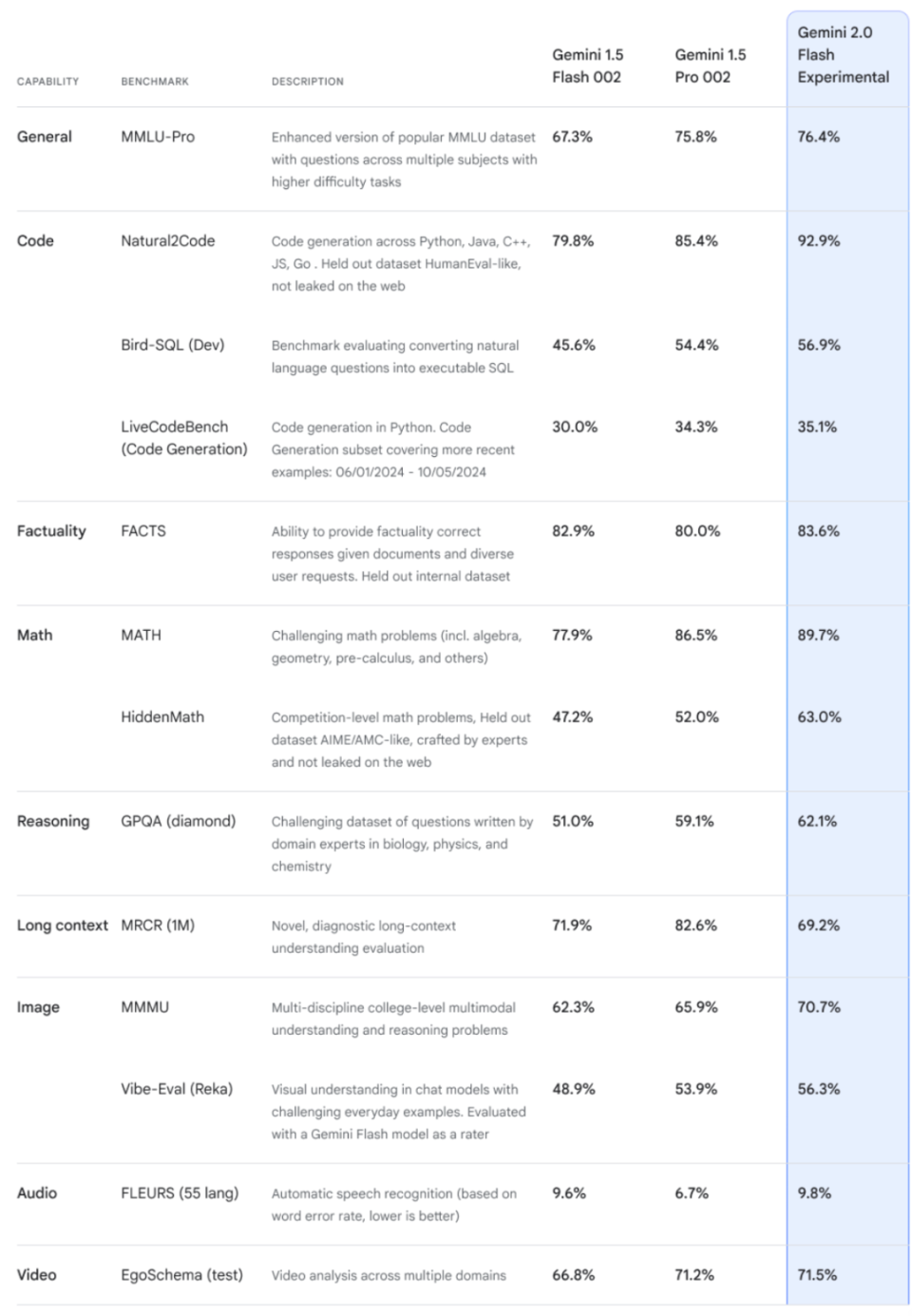

\u003cdiv class="rich_media_content"\u003e\u003csection data-exeditor-arbitrary-box="wrap"\u003e\u003cp\u003e\u003cstrong\u003e作者 | Li Yuan\u003c/strong\u003e\u003c/p\u003e\u003c/section\u003e\u003cp\u003e2024 年走到年底,似乎 AI 大厂们集体又决定搞点事情了。\u003c/p\u003e\u003cp\u003e在 OpenAI 宣布连发 12 天更新后,Google 选择 12 月 11 日深夜(在 OpenAI 发布更新之前),发布新模型 Gemini 2.0。\u003c/p\u003e\u003cp\u003e在多次发布被 OpenAI 精准狙击后,Google 今夜扳回一局,发布了 Gemini 2.0,直指 Agent 使用,一个 OpenAI 至今没有明确公开布局的领域——之前有消息称,OpenAI 将在明年推出使用电脑的 Agent。\u003c/p\u003e\u003cp\u003eAgent 功能,也称为智能体功能,通常指的是 AI 能够感知环境、执行任务并在一定程度上独立做出决策的能力,也就是能更自动化完成任务的功能。\u003c/p\u003e\u003cp\u003e此次 Google 似乎赌对了。OpenAI 凌晨两点的发布,主要宣布了和 Apple Intelligence 的合作,一个普遍被期待能与 Agent 能力强相关的合作。不过今夜最终的发布,主要仍然集中于文字生成和视觉智能方面,并没有 Agent 相关的内容。\u003c!--MID_AD_0--\u003e\u003c!--EOP_0--\u003e\u003c/p\u003e\u003c!--MID_ARTICLE_AD_0--\u003e\u003c!--PARAGRAPH_0--\u003e\u003cp\u003e而 Google,则一次性发布了四个 Agent 相关的功能:\u003c/p\u003e\u003cp\u003eProject Astra,能够在 Gemini 应用中直接调用 Google Lens 和地图功能帮用户解决问题;\u003c/p\u003e\u003cp\u003eProject Mariner(海员项目),Chrome 浏览器的实验性功能,可以通过 提示词直接帮用户浏览网页做任务;\u003c/p\u003e\u003cp\u003eJules,可以嵌入 GitHub 的编程 Agent,使用自然语言描述问题,就能直接生成可以合并到 GitHub 项目中的代码;\u003c/p\u003e\u003cp\u003e游戏 Agent,能够实时解读屏幕画面,直接在你打游戏的时候通过和你语音交流,给你 AI 打法提示。\u003c/p\u003e\u003cp\u003e虽然此次 Google 发布的功能仍然属于期货范畴,但是仍然十分令人兴奋。我们似乎已经可以洞见 Agent 真正到来的时代,人类生活的一角了。\u003c/p\u003e\u003csection data-exeditor-arbitrary-box="wrap"\u003e\u003cp\u003e\u003c/p\u003e\u003c/section\u003e\u003csection data-exeditor-arbitrary-box="wrap"\u003e\u003cp\u003e\u003ci\u003e\u003cstrong\u003e01\u003c/strong\u003e\u003c/i\u003e\u003c/p\u003e\u003cp\u003e\u003cstrong\u003e炸裂新 Agent 功能:自己查资料、写代码,教你玩游戏\u003c/strong\u003e\u003c/p\u003e\u003c/section\u003e\u003cp\u003eGoogle 的新功能建立在新模型 Gemini 2.0 能力之上。\u003c/p\u003e\u003cp\u003e和大部分大模型选择的路线不一样,Google 最早就选择了使用原生多模态的的方式训练模型——\u003c!--SECURE_LINK_BEGIN_0--\u003eOpenAI\u003c!--SECURE_LINK_END_0--\u003e 到了 GPT-4o 模型才变成原生多模态的模型。\u003c/p\u003e\u003cp\u003e原生多模态模型,是在训练阶段,就将图像、文字、语音甚至视频等多种编码,统一输入给一个模型进行学习。\u003c/p\u003e\u003cp\u003e这样,模型可以在理解了一个「事物」后,更加灵活地利用进行不同模态的生成。\u003c/p\u003e\u003cp\u003e此次 Gemini 2.0,进一步升级了原生多模态能力。模型目前直接拥有了原生的图像生成能力、音频输出能力和原生的工具应用能力。\u003c/p\u003e\u003cp\u003e原生的工具应用能力就和 Agent 的能力高度相关。Google 介绍,除此之外,新体验还来自于多模态推理、长上下文理解、复杂指令遵循和规划、组合函数调用、本地工具使用和降低延迟等方向的改进。\u003c/p\u003e\u003cp\u003e看一下 Google 提出的新功能演示:\u003c/p\u003e\u003csection data-exeditor-arbitrary-box="wrap"\u003e\u003cp style="text-align: center" data-exeditor-arbitrary-box="image-box"\u003e\u003c!--IMG_0--\u003e\u003c/p\u003e\u003cp\u003eProject Mariner 是这个系列中,笔者看起来最惊喜的演示。\u003c/p\u003e\u003c/section\u003e\u003cp\u003e主要原因可能是因为相对于其他功能,Google 的 Chrome 浏览器是笔者每天都要使用的工具,也是对工作效率影响最高的工具。而 Google 的这项试验性功能,看起来也不需要对浏览器进行过多的额外配置——只需要用到扩展程序。\u003c/p\u003e\u003cp\u003eGoogle 很懂地选了一个生产力场景,让 Chrome 打开一个表格(演示里里用的是 Google Docs,不知道这与最终的成功识别是不是有相关性)。\u003c/p\u003e\u003cp\u003e表格里有几个公司的名字。演示者打开 Chrome 的这项试验功能,让 Chrome 自己记住这几个公司名字,去网上查找这些公司的邮箱。(同样的,查找使用的是 Google 搜索,不知道是不是与最后的演示成功相关。)\u003c/p\u003e\u003cp\u003e浏览器自己打开了网页,自己点开每个公司的官网,在找到邮箱地址后,自动记住邮箱地址,关掉网页开始查找下一个公司的邮箱地址。\u003c/p\u003e\u003cp\u003e全程,用户可以在右边栏输入提示词的位置,看到模型目前在如何思考,随时停止自动操作。同时模型只会在前台运行,不会在用户看不到的标签页中运行。\u003c/p\u003e\u003cp\u003e虽然前台运行似乎对用户的时间是一种消耗,但同时也保证了安全性。在这个案例中,也确实提升了生产效率——挨个查找邮箱确实是一件非常没有创造力的工作。\u003c/p\u003e\u003csection data-exeditor-arbitrary-box="wrap"\u003e\u003cp style="text-align: center" data-exeditor-arbitrary-box="image-box"\u003e\u003c!--IMG_1--\u003e\u003c/p\u003e\u003cp\u003eJules,则让自然语言写代码似乎更近了一步。\u003c/p\u003e\u003c/section\u003e\u003cp\u003e在演示中,用户输入了一段非常详细的编程问题的提示词,包括在哪个文件中遇到什么问题,希望做怎样的修改。(Google 提到 Jules 可以直接嵌入 GitHub 中。)\u003c/p\u003e\u003cp\u003eJules 对问题进行分析,给出了一个三步的编程解决方案,当用户点击同意后,模型开始自动编程,生成代码文件,这些代码可以一键被合并至用户原有的代码中。\u003c/p\u003e\u003csection data-exeditor-arbitrary-box="wrap"\u003e\u003cp style="text-align: center" data-exeditor-arbitrary-box="image-box"\u003e\u003c!--IMG_2--\u003e\u003c/p\u003e\u003cp\u003e游戏 Agent,则是看起来最有趣的一个演示。\u003c/p\u003e\u003c/section\u003e\u003cp\u003eGoogle 特意提到,Gemini 2.0 可以理解 Android 手机的屏幕分享和用户的语音,直接做到演示中的内容,不需要额外的后训练。\u003c/p\u003e\u003cp\u003e演示中,用户分享正在玩的手机屏,并用语音和 Agent 沟通,游戏 Agent 直接给出了接下来的最佳策略。\u003c/p\u003e\u003cp\u003eGoogle 表示目前正在和《\u003c!--SECURE_LINK_BEGIN_1--\u003e部落冲突\u003c!--SECURE_LINK_END_1--\u003e》、《海岛奇兵》等游戏做合作,帮助 Agent 理解游戏规则。同时 Agent 也会自己实时上网查找,来理解游戏规则给出最好的策略。\u003c/p\u003e\u003cp\u003e这个功能也可以说很炸裂了。对于纯策略型游戏,这个外挂可有点太厉害了——随着 AI 的进展,人脑对策略的理解恐怕没有办法和 AI 抗衡。或者说,或许只有最顶尖的大脑可以和 AI 相抗衡。\u003c/p\u003e\u003cp\u003eGemini2.0 目前并没有对全部用户开放,Google 表示目前正在将 2.0 开放给开发者以及受信任的测试人员。这意味着以上的 Agent 功能,到用户真正能够使用,仍然有一段时间。不过此次演示仍然令人兴奋。\u003c/p\u003e\u003cp\u003e未来 Gemini 2.0 上线,Google 大概率也不会首发上述的 Agent 功能,而是将先将其融入 Gemini 和搜索功能。\u003c/p\u003e\u003cp\u003eGoogle 之前已经在探索将 AI 引入其搜索功能中。10 月,Google 曾经宣布,其搜索中的 AI 概述功能每月获得了 10 亿用户的使用。未来 Google 计划把 Gemini 2.0 的高级推理能力引入 AI 概述,以应对更复杂的话题和多步骤问题,包括高级数学方程式、多模态查询和编码。\u003c!--MID_AD_1--\u003e\u003c!--EOP_1--\u003e\u003c/p\u003e\u003c!--MID_ARTICLE_AD_1--\u003e\u003c!--PARAGRAPH_1--\u003e\u003cp\u003e此外,除了探索虚拟世界的智能体能力外,Google 还打算将 Gemini 2.0 的空间推理能力应用于机器人领域,尝试让 Agent 在现实世界中提供帮助。\u003c/p\u003e\u003csection data-exeditor-arbitrary-box="wrap"\u003e\u003cp\u003e\u003ci\u003e\u003cstrong\u003e02\u003c/strong\u003e\u003c/i\u003e\u003c/p\u003e\u003cp\u003e\u003cstrong\u003eGemini Flash 常规更新\u003c/strong\u003e\u003c/p\u003e\u003c/section\u003e\u003cp\u003e那么用户实际上能够马上使用的模型是什么?\u003c/p\u003e\u003cp\u003e答案是 Gemini 2.0 Flash。\u003c/p\u003e\u003cp\u003e作为 Google 大号模型蒸馏而来的小号模型,Gemini 2.0 Flash(对话优化版本)将成为 Google Gemini 中的默认使用模型。\u003c/p\u003e\u003cp\u003eGoogle 还推出了一项名为「深度研究」的新功能,该功能利用高级推理和长上下文能力作为研究助手,可以探索复杂主题并编制报告,今天在 Gemini 高级版中可用。\u003c/p\u003e\u003cp\u003eGemini 2.0 Flash 的能力较上一代有明显提升,相当于上一代模型的 Pro 版本的能力。\u003c/p\u003e\u003cp data-exeditor-arbitrary-box="image-box"\u003e\u003c!--IMG_3--\u003e\u003c/p\u003e\u003csection data-exeditor-arbitrary-box="wrap"\u003e\u003cp\u003e\u003c/p\u003e\u003c/section\u003e\u003csection data-exeditor-arbitrary-box="wrap"\u003e\u003cp\u003e同时作为 2.0 模型家族的一员,Gemini 2.0 Flash 也支持支持图片、视频和音频等多模态输入,2.0 Flash 现在还可以支持多模态输出,例如可以直接生成图像与文本混合的内容,以及原生生成可控的多语言文本转语音 (TTS) 音频。它还可以原生调用 Google Search、代码执行以及第三方用户定义的函数等工具。\u003c/p\u003e\u003c!--MID_AD_2--\u003e\u003c!--EOP_2--\u003e\u003c/section\u003e\u003c!--MID_ARTICLE_AD_2--\u003e\u003c!--PARAGRAPH_2--\u003e\u003csection data-exeditor-arbitrary-box="wrap"\u003e\u003cp\u003e\u003ci\u003e\u003cstrong\u003e03\u003c/strong\u003e\u003c/i\u003e\u003c/p\u003e\u003cp\u003e\u003cstrong\u003eProject Astra:为 Google Glasses 准备的模型,拥有无限记忆?\u003c/strong\u003e\u003c/p\u003e\u003c/section\u003e\u003cp\u003eGoogle 此次还重点介绍了 Project Astra,为其推出了以下改进:\u003c/p\u003e\u003cp\u003e·更流畅的对话:Project Astra 现在可以在多种语言和混合语言之间进行对话,并且能够更好地理解不同口音和生僻单词。\u003c/p\u003e\u003cp\u003e·新工具的使用:借助 Gemini 2.0,Project Astra 可以使用 Google Search、Google Lens 和 Google Maps,从而在日常生活中更好地发挥助手作用。\u003c/p\u003e\u003cp\u003e·更强的记忆力:我们增强了 Project Astra 的记忆能力,同时确保你可以掌控对话。现在,它最多可以记住长达 10 分钟的会话内容,并且可以回忆起过去与它进行的更多对话,以便为您提供更好的个性化服务。 \u003c/p\u003e\u003cp\u003e·更低的延迟:借助新的流式处理技术和原生音频理解能力,该智能体能够以近于人类对话的延迟来理解语言。\u003c/p\u003e\u003cp\u003eGoogle Astra 是 Google 为了眼镜项目所做的前瞻项目。\u003c/p\u003e\u003cp\u003e从 \u003c!--SECURE_LINK_BEGIN_2--\u003eMeta 和 Ray-ban 的合作眼镜\u003c!--SECURE_LINK_END_2--\u003e开始,国内外的不少公司,已经又在重新探索眼镜作为新一代智能硬件的潜力。\u003c/p\u003e\u003cp\u003e此次 Google 重大更新之一,是记忆能力。在外网采访中,DeepMind 的 CEO Demis Hassabis 表示,在 Gemini 1.5 时代,内部测试中,已经将其上下文窗口扩展到了 1000 万个 token 以上。目前已经模型几乎可以做到无限记忆。\u003c!--MID_AD_3--\u003e\u003c!--EOP_3--\u003e\u003c/p\u003e\u003c!--MID_ARTICLE_AD_3--\u003e\u003c!--PARAGRAPH_3--\u003e\u003cp\u003e但是代价就是速度。记忆越长,搜索相关记忆的成本越高,速度越低。不过 Demis Hassabis 认为,接下来相当短的时间内,我们将真正拥有无限长的上下文。\u003c/p\u003e\u003cp\u003e而这对于 Google 真正想做的助手而言是极其重要的。Demis Hassabis 形容未来世界:「你在电脑上使用这一助手,然后你走出家门,戴上眼镜,或者使用手机,它一直都在。它能够记住会话以及你想要做什么,真正个性化。我们人类无法记住所有事情,而AIvu u会记住所有事情,来给你以灵感和新的规划。」\u003c!--MID_AD_4--\u003e\u003c!--EOP_4--\u003e\u003c/p\u003e\u003c!--MID_ARTICLE_AD_4--\u003e\u003c!--PARAGRAPH_4--\u003e\u003csection data-exeditor-arbitrary-box="wrap"\u003e\u003cp\u003e\u003ci\u003e\u003cstrong\u003e04\u003c/strong\u003e\u003c/i\u003e\u003c/p\u003e\u003c/section\u003e\u003csection data-exeditor-arbitrary-box="wrap"\u003e\u003cp\u003e\u003cstrong\u003eAgent 时代已来?\u003c/strong\u003e\u003c/p\u003e\u003c/section\u003e\u003cp\u003e从去年开始,就陆续有人指出 Agent 是 AI 发展的未来。\u003c/p\u003e\u003cp\u003e不过,在过去一年中,Agent 这个词的使用相对比较沉寂,甚至有时候被偷换概念当成 AI 应用来使用。\u003c/p\u003e\u003cp\u003e但是在今年年末,我们终于开始看到了相对可喜的进展。\u003c/p\u003e\u003cp\u003e首先是 Anthropic,推出电脑使用的 Agent 模式。\u003c/p\u003e\u003cp\u003e国内的智谱 AI,也推出了一个手机 Agent 替用户操作微信等 App 的的演示视频。\u003c/p\u003e\u003cp\u003e明年的 OpenAI 与苹果合作的 Apple Intelligence,目前仍然不确定全貌。很多人期待它将让许多用户第一次在手机上体会到简单的 Agent 功能到底能如何帮助我们提升生产力。\u003c/p\u003e\u003cp\u003e而现在我们又看到 Google 推出的浏览器 Agent 和安卓手机上的 Agent 使用演示。\u003c/p\u003e\u003cp\u003eAgent 技术依然面临诸多挑战。人们会担忧误操作可能带来的安全隐患,会担心隐私,会担心一系列风险。\u003c/p\u003e\u003cp\u003e但同时,对于普通用户而言,Agent 才是最具「AI 感」的技术。全自动的任务完成,像魔法一般,不需要任何技术背景,直接就能提升工作效率和使用体验。\u003c/p\u003e\u003cp\u003eAgent 能力的提升,也为一个新的智能硬件真正进入人们生活打下了基础——只有发出语音指令,眼镜能直接自动完成部分任务的时候,许多任务才会逐渐从手机转移至新的智能硬件终端。\u003c/p\u003e\u003cp\u003e或许真的如 Google AI Studio 的产品负责人 Logan Kilpatrick 今天早些时候所言:未来,是 Agent 的时代。\u003c/p\u003e\u003cdiv powered-by="qqnews_ex-editor"\u003e\u003c/div\u003e\u003cstyle\u003e.rich_media_content{--news-tabel-th-night-color: #444444;--news-font-day-color: #333;--news-font-night-color: #d9d9d9;--news-bottom-distance: 22px}.rich_media_content p:not([data-exeditor-arbitrary-box=image-box]){letter-spacing:.5px;line-height:30px;margin-bottom:var(--news-bottom-distance);word-wrap:break-word}.rich_media_content{color:var(--news-font-day-color);font-size:18px}@media(prefers-color-scheme:dark){body:not([data-weui-theme=light]) .rich_media_content p:not([data-exeditor-arbitrary-box=image-box]){letter-spacing:.5px;line-height:30px;margin-bottom:var(--news-bottom-distance);word-wrap:break-word}body:not([data-weui-theme=light]) .rich_media_content{color:var(--news-font-night-color)}}.data_color_scheme_dark .rich_media_content p:not([data-exeditor-arbitrary-box=image-box]){letter-spacing:.5px;line-height:30px;margin-bottom:var(--news-bottom-distance);word-wrap:break-word}.data_color_scheme_dark .rich_media_content{color:var(--news-font-night-color)}.data_color_scheme_dark .rich_media_content{font-size:18px}.rich_media_content p[data-exeditor-arbitrary-box=image-box]{margin-bottom:11px}.rich_media_content\u003ediv:not(.qnt-video),.rich_media_content\u003esection{margin-bottom:var(--news-bottom-distance)}.rich_media_content hr{margin-bottom:var(--news-bottom-distance)}.rich_media_content .link_list{margin:0;margin-top:20px;min-height:0!important}.rich_media_content blockquote{background:#f9f9f9;border-left:6px solid #ccc;margin:1.5em 10px;padding:.5em 10px}.rich_media_content blockquote p{margin-bottom:0!important}.data_color_scheme_dark .rich_media_content blockquote{background:#323232}@media(prefers-color-scheme:dark){body:not([data-weui-theme=light]) .rich_media_content blockquote{background:#323232}}.rich_media_content ol[data-ex-list]{--ol-start: 1;--ol-list-style-type: decimal;list-style-type:none;counter-reset:olCounter calc(var(--ol-start,1) - 1);position:relative}.rich_media_content ol[data-ex-list]\u003eli\u003e:first-child::before{content:counter(olCounter,var(--ol-list-style-type)) '. ';counter-increment:olCounter;font-variant-numeric:tabular-nums;display:inline-block}.rich_media_content ul[data-ex-list]{--ul-list-style-type: circle;list-style-type:none;position:relative}.rich_media_content ul[data-ex-list].nonUnicode-list-style-type\u003eli\u003e:first-child::before{content:var(--ul-list-style-type) ' ';font-variant-numeric:tabular-nums;display:inline-block;transform:scale(0.5)}.rich_media_content ul[data-ex-list].unicode-list-style-type\u003eli\u003e:first-child::before{content:var(--ul-list-style-type) ' ';font-variant-numeric:tabular-nums;display:inline-block;transform:scale(0.8)}.rich_media_content ol:not([data-ex-list]){padding-left:revert}.rich_media_content ul:not([data-ex-list]){padding-left:revert}.rich_media_content table{display:table;border-collapse:collapse;margin-bottom:var(--news-bottom-distance)}.rich_media_content table th,.rich_media_content table td{word-wrap:break-word;border:1px solid #ddd;white-space:nowrap;padding:2px 5px}.rich_media_content table th{font-weight:700;background-color:#f0f0f0;text-align:left}.rich_media_content table p{margin-bottom:0!important}.data_color_scheme_dark .rich_media_content table th{background:var(--news-tabel-th-night-color)}@media(prefers-color-scheme:dark){body:not([data-weui-theme=light]) .rich_media_content table th{background:var(--news-tabel-th-night-color)}}.rich_media_content .qqnews_image_desc,.rich_media_content p[type=om-image-desc]{line-height:20px!important;text-align:center!important;font-size:14px!important;color:#666!important}.rich_media_content div[data-exeditor-arbitrary-box=wrap]:not([data-exeditor-arbitrary-box-special-style]){max-width:100%}.rich_media_content .qqnews-content{--wmfont: 0;--wmcolor: transparent;font-size:var(--wmfont);color:var(--wmcolor);line-height:var(--wmfont)!important;margin-bottom:var(--wmfont)!important}.rich_media_content .qqnews_sign_emphasis{background:#f7f7f7}.rich_media_content .qqnews_sign_emphasis ol{word-wrap:break-word;border:none;color:#5c5c5c;line-height:28px;list-style:none;margin:14px 0 6px;padding:16px 15px 4px}.rich_media_content .qqnews_sign_emphasis p{margin-bottom:12px!important}.rich_media_content .qqnews_sign_emphasis ol\u003eli\u003ep{padding-left:30px}.rich_media_content .qqnews_sign_emphasis ol\u003eli{list-style:none}.rich_media_content .qqnews_sign_emphasis ol\u003eli\u003ep:first-child::before{margin-left:-30px;content:counter(olCounter,decimal) ''!important;counter-increment:olCounter!important;font-variant-numeric:tabular-nums!important;background:#37f;border-radius:2px;color:#fff;font-size:15px;font-style:normal;text-align:center;line-height:18px;width:18px;height:18px;margin-right:12px;position:relative;top:-1px}.data_color_scheme_dark .rich_media_content .qqnews_sign_emphasis{background:#262626}.data_color_scheme_dark .rich_media_content .qqnews_sign_emphasis ol\u003eli\u003ep{color:#a9a9a9}@media(prefers-color-scheme:dark){body:not([data-weui-theme=light]) .rich_media_content .qqnews_sign_emphasis{background:#262626}body:not([data-weui-theme=light]) .rich_media_content .qqnews_sign_emphasis ol\u003eli\u003ep{color:#a9a9a9}}.rich_media_content h1,.rich_media_content h2,.rich_media_content h3,.rich_media_content h4,.rich_media_content h5,.rich_media_content h6{margin-bottom:var(--news-bottom-distance);font-weight:700}.rich_media_content h1{font-size:20px}.rich_media_content h2,.rich_media_content h3{font-size:19px}.rich_media_content h4,.rich_media_content h5,.rich_media_content h6{font-size:18px}.rich_media_content li:empty{display:none}.rich_media_content ul,.rich_media_content ol{margin-bottom:var(--news-bottom-distance)}.rich_media_content div\u003ep:only-child{margin-bottom:0!important}.rich_media_content .cms-cke-widget-title-wrap p{margin-bottom:0!important}\u003c/style\u003e\u003c/div\u003e

本文来自作者[念珊三岁啦]投稿,不代表蔚蓝之海立场,如若转载,请注明出处:https://foryh.cn/wiki/32516.html

评论列表(4条)

我是蔚蓝之海的签约作者“念珊三岁啦”!

希望本篇文章《Google深夜狙击OpenAI:新Agent功能可以自己打开浏览器查资料了_腾讯新闻》能对你有所帮助!

本站[蔚蓝之海]内容主要涵盖:生活百科,小常识等内容......

本文概览:######### \u003cdiv class="rich_media_content"\u003e\u003csection data-exeditor-arbitrar...