###

###

###

###

###

###

###

###

###

###

###

###

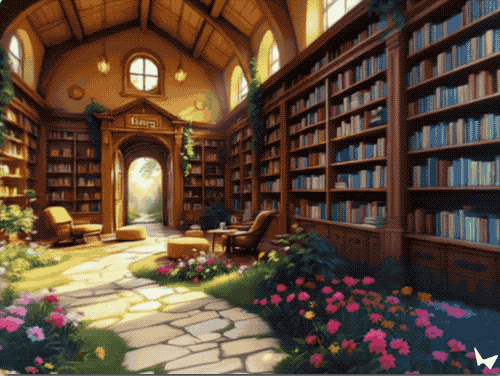

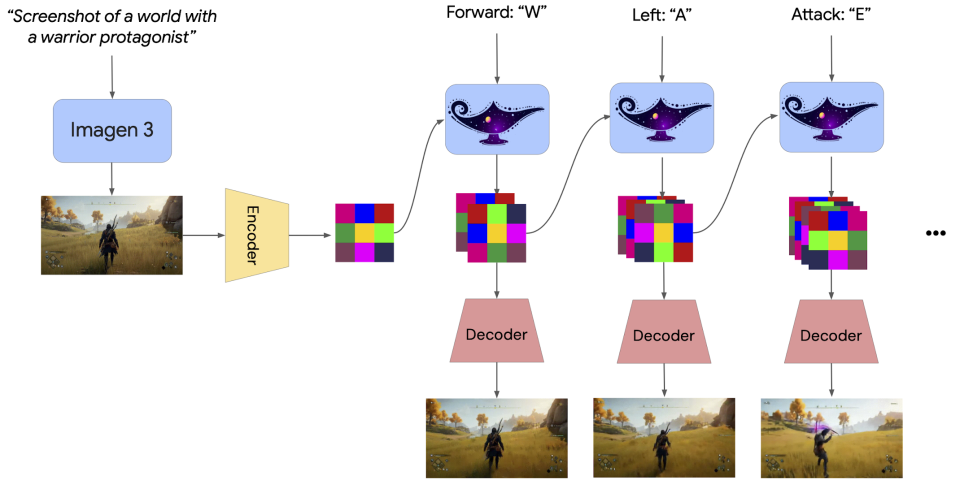

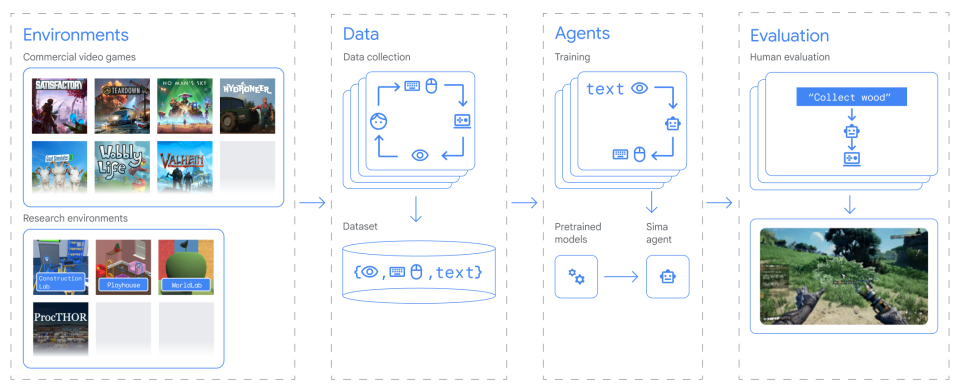

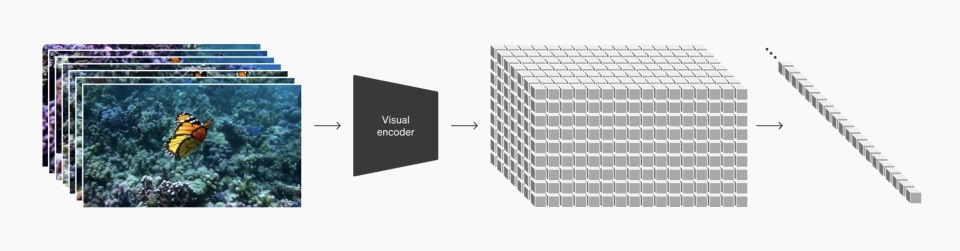

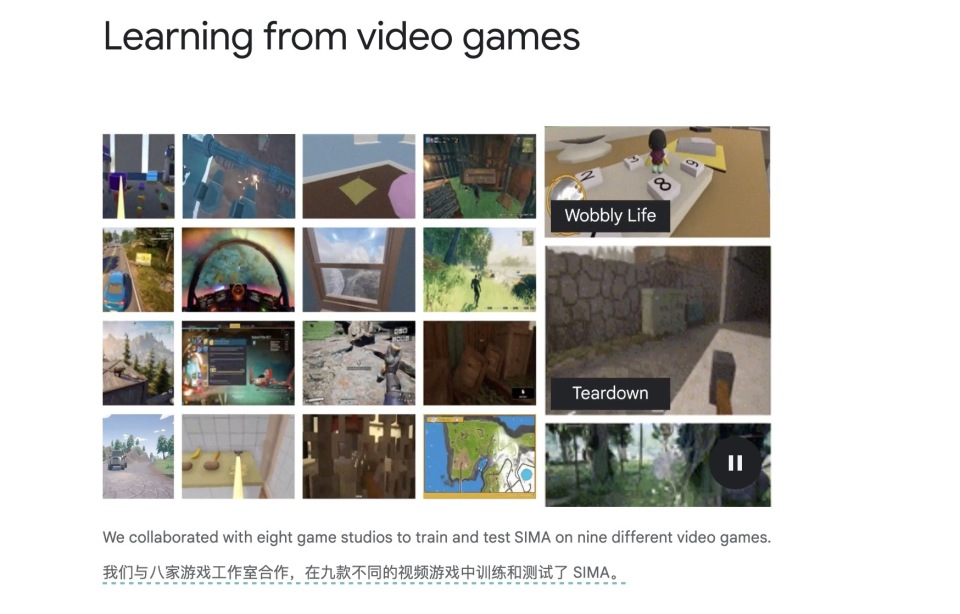

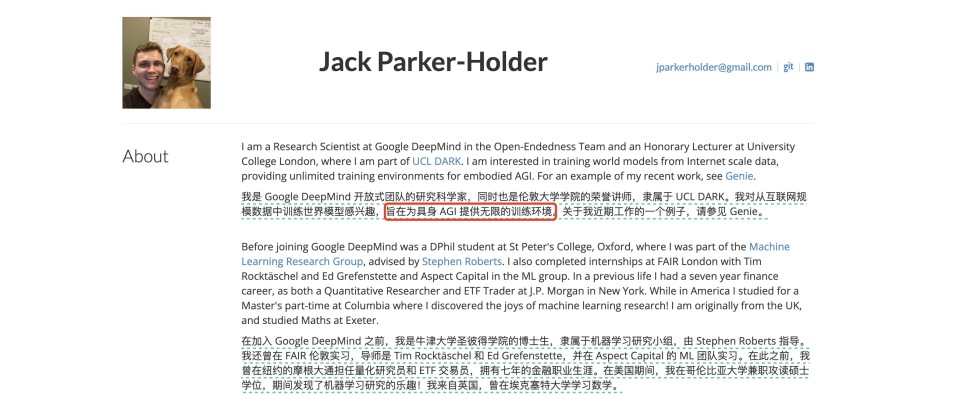

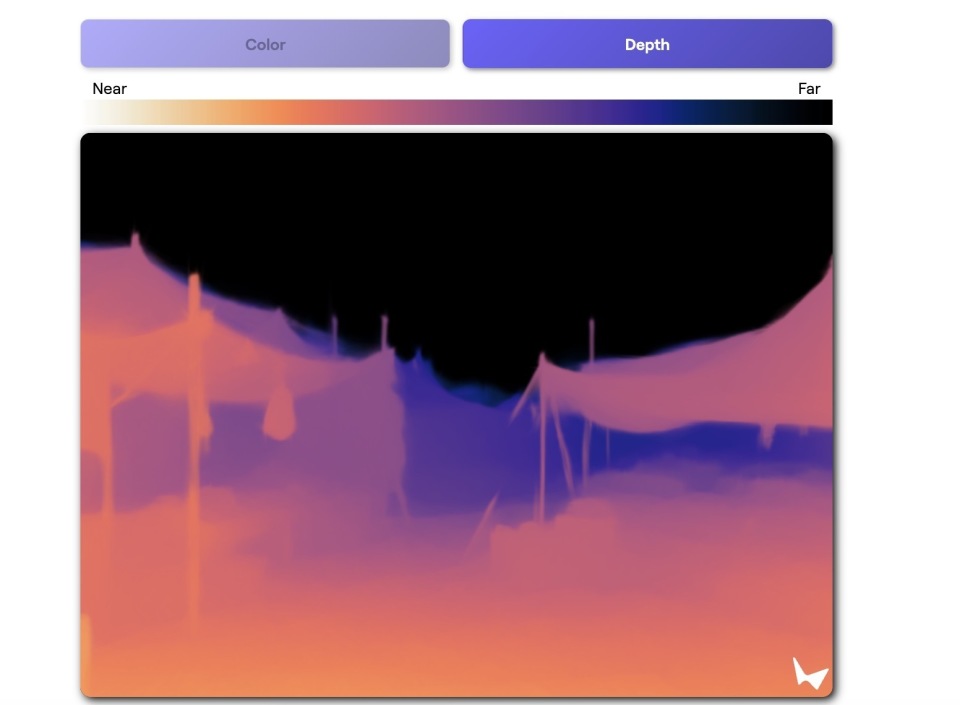

\u003cdiv class="rich_media_content"\u003e\u003cp\u003e《AI未来指北》特约作者 郝博阳\u003c/p\u003e\u003cp\u003e编辑 郑可君\u003c/p\u003e\u003cp\u003e\u003cstrong\u003e划重点:\u003c/strong\u003e\u003c/p\u003e\u003cdiv class="qqnews_sign_emphasis" data-exeditor-arbitrary-box="wrap"\u003e\u003col classname="ex-list" data-ex-list="ol" data-list-style-type="decimal" style="--ol-list-style-type: decimal"\u003e\u003cli\u003e\u003cp\u003e2024年12月4日,谷歌发布Genie 2,实现了从静态照片到可交互3D场景的转换,虽然只能维持几十秒,但细致程度和互动流畅性都达到了新高度。\u003c/p\u003e\u003c/li\u003e\u003cli\u003e\u003cp\u003e当前构建数字世界有三条路线:OpenAI的Sora追求视觉真实,谷歌的Genie 2注重实时交互,World Labs专注空间准确。这三条路线各有优势,也各有无法在短期内解决的问题。\u003c/p\u003e\u003c/li\u003e\u003cli\u003e\u003cp\u003e未来AI的世界构建需要在这三种技术路线中找到更恰当的融合方式,而AI生成游戏可能还有很长的路要走。\u003c/p\u003e\u003c/li\u003e\u003c/ol\u003e\u003c!--MID_AD_0--\u003e\u003c!--EOP_0--\u003e\u003c/div\u003e\u003c!--MID_ARTICLE_AD_0--\u003e\u003c!--PARAGRAPH_0--\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e2024年12月4日,Google DeepMind默默放出了一颗重磅炸弹:\u003cstrong\u003e一个能把静态照片变成可玩游戏的AI系统。\u003c/strong\u003e\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e系统名叫Genie 2,能把照片变成可探索的3D世界,用户使用键盘及鼠标输入就可以操控并完成与环境的互动。\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e而在两天前,李飞飞的World Labs刚刚推出他们版本的世界创造模型。同样是给系统一张照片,用AI让它变成漫步其中的三维空间,可以进行互动,但模式并没有Genie 2丰富。\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e在腾讯科技《AI未来指北》之前的报道《\u003c!--LINK_0--\u003e》中,我们也罗列了这一模型明显的长项和缺陷。\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e而在12月之前,3D世界生成受到的关注其实并没那么大。\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e比如在今年11月,两家名不见经传的创业公司Decart和Etched,它们用推出的AI系统Oasis搭建了一个可玩的AI生成的《我的世界》;谷歌Deepmind也在同月放出了首个AI游戏引擎GameNGen ,能生成了《毁灭公爵3D》(一款在1996年1月29日发行的第一人称视角游戏,是最早在无显卡情况下能模拟3D场景的FPS游戏之一)。\u003c!--MID_AD_1--\u003e\u003c!--EOP_1--\u003e\u003c/p\u003e\u003c!--MID_ARTICLE_AD_1--\u003e\u003c!--PARAGRAPH_1--\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e它们都很酷炫,但都只能用于非常有限制的单个游戏,而且画质都差不多仅能达到360p的水平。\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e然而一个月之后,AI的顶流们就不再满足于生成这种“小品”级互动游戏世界了,它开始追求更大的野心:创造完整、清晰、细节更丰富的数字宇宙。而且,是一个泛化的适应于各种场景和风格的世界。\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e他们把它称作AI生成的“世界模型”。它们的路线有何异同?哪个更接近真正的“世界模拟器”呢?\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003ch2\u003e\u003c!--HPOS_0--\u003e\u003cstrong\u003e世界模型Genie 2,为什么好到马斯克都说酷?\u003c/strong\u003e\u003c/h2\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e我们先来看看今天的主角——谷歌新产品Genie 2。\u003c/p\u003e\u003cp data-exeditor-arbitrary-box="image-box"\u003e\u003c!--IMG_0--\u003e\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e它的水平好到什么程度?能让马斯克都说酷。\u003c/p\u003e\u003cp data-exeditor-arbitrary-box="image-box"\u003e\u003c!--IMG_1--\u003e\u003c/p\u003e\u003cp style="text-align: center" class="qqnews_image_desc"\u003e\u003cspan style="font-size: 14px"\u003e\u003cspan style="color: rgb(102, 102, 102)"\u003e(马斯克在Hassabis发布的推文下的回复)\u003c/span\u003e\u003c/span\u003e\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e首先,它的画面相当清晰,细节丰富,几乎与PS3世代的游戏无异。\u003c/p\u003e\u003c!--VIDEO_0--\u003e\u003cp type="desc" style="color: rgb(136, 136, 136); font-size: 13px; line-height: 14px; margin-bottom: 22px; margin-top: 8px; text-align: center"\u003e\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e这得益于其生成技术的迭代。\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003eGenie 2的生成逻辑和Sora的DiT( Diffusion Transformers)技术差异不大。它使用了DeepMind最新的文生图模型Imagen 3生成初始画面。然后通过一个自回归潜在扩散模型(Autoregressive Latent Diffusion Model),系统能将这个平面图像\u0026#34;扩展\u0026#34;成一个完整的3D空间。\u003c!--MID_AD_2--\u003e\u003c!--EOP_2--\u003e\u003c/p\u003e\u003c!--MID_ARTICLE_AD_2--\u003e\u003c!--PARAGRAPH_2--\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e这个过程中,视频首先经过自动编码器处理,提取出潜在帧信息,然后传递给一个采用因果掩码训练的大型Transformer模型来去处理的空间信息和事件信息。一个Diffusion编码器和一个Transformer的序列,这就是DiT的基本架构。\u003c!--MID_AD_3--\u003e\u003c!--EOP_3--\u003e\u003c/p\u003e\u003c!--MID_ARTICLE_AD_3--\u003e\u003c!--PARAGRAPH_3--\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e但和Sora所不同的是,Genie 2引入了一个可操控的智能体。\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e为了实现操控,在推理阶段,它能同时引入基于过去的潜在帧和当前的动作输入,以自回归方式生成新的画面。\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e为了提高动作的可控性,研究团队还引入了无分类器引导(Classifier-free Guidance)技术,这让系统能够更准确地响应用户输入。\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e\u003cstrong\u003e比如当你在键盘上按下方向键时,系统能自动识别场景中的可控制对象(比如玩家角色),而不是移动背景元素(如树木或云朵)。\u003c/strong\u003e\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e这对于过往的AI来说是个不小的挑战。它需要理解场景中物体的层级关系、物理属性和交互规则。而这种智能识别能力来自于另一个谷歌项目SIMA在海量视频数据集上的训练,系统通过学会了区分场景中的动态元素和静态背景,并理解了交互的逻辑。\u003c/p\u003e\u003cp\u003e同时,SIMA还通过模拟反事实体验(counterfactual experiences)训练智能体,从“假如当时采取另一种行动会怎样”中获得经验,拓展了物体交互和角色动画统一的可能性。\u003c/p\u003e\u003cp data-exeditor-arbitrary-box="image-box"\u003e\u003c!--IMG_2--\u003e\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e借由DiT的加持,这一系统表现出非凡的涌现能力。比如说,当你在水中游泳时,水面会自然地泛起涟漪,当阳光透过树叶时,地面会出现斑驳的光影;就连烟雾的扩散,都遵循着基本的物理规律。\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e在渲染方面,Genie 2实现了一个相当完整的物理光照系统。它不仅能处理直接光照,还能计算全局光照、材质反射,甚至能生成实时动态阴影。这些效果的质量虽然还比不上顶级游戏引擎,但考虑到这是实时生成的,已经相当惊人。\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e特别值得一提的是其场景记忆机制。系统能够维持长达一分钟的场景连贯性,这意味着它不仅要记住可见部分的状态,还要推断和维护不可见区域的信息。这个技术难点的解决让Genie 2得以创造出真正一致性的3D环境。\u003c/p\u003e\u003c!--VIDEO_1--\u003e\u003cp type="desc" style="color: rgb(136, 136, 136); font-size: 13px; line-height: 14px; margin-bottom: 22px; margin-top: 8px; text-align: center"\u003e\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e这么看确实很惊艳。比起9个月前发布的第一代Genie,Genie 2在从2D到3D维度提升、交互深度和物理模拟上都实现了极大的跃迁。\u003c/p\u003e\u003cp data-exeditor-arbitrary-box="image-box"\u003e\u003c!--IMG_3--\u003e\u003c/p\u003e\u003cp style="text-align: center" class="qqnews_image_desc"\u003e\u003cspan style="font-size: 14px"\u003e\u003cspan style="color: rgb(102, 102, 102)"\u003e(Genie 1 的生成效果)\u003c/span\u003e\u003c/span\u003e\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e这主要得益于用DiT架构取代了VIT架构,使得物理世界画面生成更加完善自然。\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e另外,就是Deepmind SIMA项目的参与,这一项目通过观察人类玩家在游戏中的行为学习,积累了大量关于\u0026#34;人类如何在3D空间中行动\u0026#34;的数据。这些数据可以帮助Genie 2更好地理解和模拟人类在3D空间中的动作生成和物理交互。\u003c/p\u003e\u003cp data-exeditor-arbitrary-box="image-box"\u003e\u003c!--IMG_4--\u003e\u003c/p\u003e\u003cp style="text-align: center" class="qqnews_image_desc"\u003e\u003cspan style="font-size: 14px"\u003e\u003cspan style="color: rgb(102, 102, 102)"\u003e(SIMA的训练逻辑)\u003c/span\u003e\u003c/span\u003e\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e但是,就像所有开创性的技术一样,Genie 2也面临着一些严峻的挑战。\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e由于训练数据的限制,在实际应用中还存在一定\u0026#34;失误\u0026#34;:比如有时系统会生成违反上下文的内容(比如在花园里生成鬼魂)。\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e或者突然改变场景的物理规则(如滑雪者突然开始跑酷)。\u003c/p\u003e\u003c!--VIDEO_2--\u003e\u003cp type="desc" style="color: rgb(136, 136, 136); font-size: 13px; line-height: 14px; margin-bottom: 22px; margin-top: 8px; text-align: center"\u003e\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e这些问题反映出AI在长期叙事连贯性和场景一致性方面还需要改进。\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e但最明显的问题是持续时间限制——目前Genie的生成大多数情况下只维持10-20秒,最多也就是生成1分钟的连续场景。\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e这是因为Transformer自身的限制,导致其计算量随时间会呈指数增长,误差也会持续累积。\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e在当前非蒸馏情况下,内存的消耗极大,无法延展生成。这些问题类似于在去年大语言模型遇到的上下文瓶颈。而直到现在,AI图像生成模型仍未有效突破这些难点,毕竟它的计算量级比文字要大得多。\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e因此,游戏设计师们暂时还不用太担心,生成游戏并不会马上取代手操世界建构,没人会去玩一个只能持续几十秒的游戏。\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003ch2\u003e\u003c!--HPOS_1--\u003e\u003cstrong\u003e李飞飞、OpenAI、谷歌,三条构建世界之路\u003c/strong\u003e\u003c/h2\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e在2024年,有三家公司都声称自己在“生成世界”,或者在“构建世界模型”。\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e不同于传统的游戏开发或3D建模,AI世界模型(World Model)的目标更为宏大:它试图创造一个既符合物理规律,又能实时响应交互,还要视觉真实的完整数字宇宙。这个世界是\u0026#34;活\u0026#34;的——它能实时响应你的每一个动作,就像现实世界一样。这不再是简单的视频生成或3D渲染,而是一次完整的物理世界的数字重构。\u003c!--MID_AD_4--\u003e\u003c!--EOP_4--\u003e\u003c/p\u003e\u003c!--MID_ARTICLE_AD_4--\u003e\u003c!--PARAGRAPH_4--\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e在这场雄心勃勃的技术竞赛中,三家公司的技术路线正在同时推进:\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e● OpenAI的Sora追求极致的视觉真实感,用扩散模型编织时空连续性;\u003c/p\u003e\u003cp\u003e● Google的Genie 2致力于创造可交互的动态世界,通过自回归生成实现实时响应;\u003c/p\u003e\u003cp\u003e● 而李飞飞团队的World Labs则专注于空间的几何精确性,用点云技术构建稳定的三维结构。\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e如果说创造数字世界像是编织一块巨大的时空织物,那么Sora就是一台精密的织布机。\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e它采用了一种独特的时空扩散模型(Spatiotemporal Diffusion Model),能够同时处理空间和时间维度的信息。这种方法让Sora不仅能生成令人惊叹的画面,更重要的是能保持时间维度上的连贯性。\u003c/p\u003e\u003cp data-exeditor-arbitrary-box="image-box"\u003e\u003c!--IMG_5--\u003e\u003c/p\u003e\u003cp style="text-align: center" class="qqnews_image_desc"\u003e\u003cspan style="font-size: 14px"\u003e\u003cspan style="color: rgb(102, 102, 102)"\u003e(Sora的DiT架构)\u003c/span\u003e\u003c/span\u003e\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e在Sora编织的世界里,通过海量的视频数据训练,模型可以模拟出一些经常出现的“物理规则”。\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e因此,物体与物体之间的交互逻辑在很多时候都比较拟真。然而与一般的模型幻觉类似,当遇到不那么“典型”的状况时,Sora非常容易翻车,无法真正的模拟出物理交互。\u003c/p\u003e\u003cp data-exeditor-arbitrary-box="image-box"\u003e\u003c!--IMG_6--\u003e\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e而且Sora需要直接生成一整个视频片段,因其需要的巨大计算量级,实时生成基本是不可能的。\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e\u003cstrong\u003e这就是第一条路线:试图用AI模型直接模拟真实世界的物理规则,搭建起一套完全符合物理世界的模型。\u003c/strong\u003e\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e而谷歌的Genie 2更像是一个实时运行的物理引擎。它的核心是自回归潜在扩散模型(Autoregressive Latent Diffusion Model),这种架构让它能够根据当前状态实时预测和生成下一刻的场景。\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e在Sora的基础之上,Genie 2借由更多来自游戏的训练数据,因此它对3D实体间类似游戏引擎的物理模式更敏感。因为这种相比自然界的真实物理规则更为简化,模式也更单一化。因此其物理反馈的准确性比Sora要强上不少。\u003c/p\u003e\u003cp data-exeditor-arbitrary-box="image-box"\u003e\u003c!--IMG_7--\u003e\u003c/p\u003e\u003cp style="text-align: center" class="qqnews_image_desc"\u003e\u003cspan style="font-size: 14px"\u003e\u003cspan style="color: rgb(102, 102, 102)"\u003e(SIMA核心的训练基础是游戏,这又构成了Genie 2的技术核心)\u003c/span\u003e\u003c/span\u003e\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e同时它还引入了“操控”,制造了一个不光可以看,更可以进行交互的世界。而通过在自回归模型中加入了反馈生成,Genie为这个世界加入了可控性交互。因为可控,这个世界还需要能够“实时”生成,才可能考虑到因为动作反馈带来的未来变化。\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e从Genie团队的构成,我们也能看到,对这个团队来讲,视频生成并非最核心的问题,智能体的交互环境的模拟才是。\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e因此,其团队中有好几个专家都是智能体,乃至机器人学方向的专家。\u003c/p\u003e\u003cp data-exeditor-arbitrary-box="image-box"\u003e\u003c!--IMG_8--\u003e\u003c/p\u003e\u003cp style="text-align: center" class="qqnews_image_desc"\u003e\u003cspan style="font-size: 14px"\u003e\u003cspan style="color: rgb(102, 102, 102)"\u003e(项目负责人Jack Parker-Holder的主页)\u003c/span\u003e\u003c/span\u003e\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e\u003cstrong\u003e这是第二条路,在Sora开创的主流DiT架构之上发展,缩小训练范围,增加实时和可互动性。构建更符合我们认知体系(也就是游戏引擎中)的物理世界。\u003c/strong\u003e\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e而李飞飞团队的World Labs则走了一条截然不同的路线。它选择直接在三维空间中构建场景。\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e\u003cstrong\u003e根据腾讯科技之前文章中的分析,World Labs很可能使用了点云技术(Point Cloud Technology)和类似于谷歌CAT3D的几何重建(Geometric Reconstruction)技术来确保空间关系的准确性。\u003c/strong\u003e\u003c/p\u003e\u003cp data-exeditor-arbitrary-box="image-box"\u003e\u003c!--IMG_9--\u003e\u003c/p\u003e\u003cp style="text-align: center" class="qqnews_image_desc"\u003e\u003cspan style="font-size: 14px"\u003e\u003cspan style="color: rgb(102, 102, 102)"\u003e(World Lab自带的景深分析)\u003c/span\u003e\u003c/span\u003e\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e从技术上看,这就像是在教一个孩子画画和教一个孩子做雕塑的区别。谷歌的Genie 2选择了\u0026#34;画家\u0026#34;的路线:它通过连续生成二维图像,再靠强大的自回归机制和记忆系统来维持世界的连贯性。\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e而World Labs则走了\u0026#34;雕塑家\u0026#34;的道路:直接在三维空间中构建场景,确保几何关系的精确性。\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e这就像是在处理一个持续变化的电影场景和构建一个静态的博物馆的区别。\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003eWorld Labs的方法能更好地保证空间的准确性和稳定性,但在处理动态变化时会受到很多限制。所以在其演示中,你能行走的范围很小,背景显得一成不变,缺乏生气,用户能和背景做的交互也相对少。\u003c/p\u003e\u003cp data-exeditor-arbitrary-box="image-box"\u003e\u003c!--IMG_10--\u003e\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e而Genie 2则更擅长处理连续的动态变化,但可能在保持长期空间一致性方面面临挑战。简单来讲就是Bug多,且你只能玩几十秒。\u003c/p\u003e\u003cp data-exeditor-arbitrary-box="image-box"\u003e\u003c!--IMG_11--\u003e\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e但更有趣的是这两种方法背后的哲学差异。World Labs的方案体现了一种\u0026#34;结构优先\u0026#34;的思维:先确保空间的正确性,再填充动态内容。这种方法更接近传统的3D建模思路,但使用AI来自动化这个过程。\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e\u003cstrong\u003e而谷歌的方案则体现了一种\u0026#34;体验优先\u0026#34;的理念:通过持续的预测和生成来创造连贯的体验,即便可能在某些细节上不够完美。\u003c/strong\u003e\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e\u003cstrong\u003e这就是第三条路,先搭场景,然后把用户放进场景去互动。\u003c/strong\u003e\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e这三种技术路线各有优势,也各有局限,很难说谁才是真正模拟世界的方式。\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e而这场技术角力揭示了构建数字宇宙的三个核心挑战:视觉真实性、交互自然性和空间准确性,每种技术路线都在试图以自己的方式解决这些问题。\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003eSora在视觉质量和时序连贯性上表现出色,视觉真实性高,对真实世界物理规则的还原更有野心,但缺乏交互能力和准确性。\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003eGenie 2的实时交互能力强,但在视觉质量和细微物理还原上做出了让步。World Labs在空间准确性上领先,但在动态效果和交互性上聊胜于无。\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e如果未来的框架技术没有非常大的进展,很可能首款AI制作的3A级游戏的突破可能来自这三种技术的融合。\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e我们可以想象一个结合了Sora的视觉质量、Genie 2的交互能力和World Labs空间准确性的混合系统。这种系统可能采用混合渲染管线(Hybrid Rendering Pipeline),在不同场景下动态切换不同的渲染策略。\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e就类似于早期我们因为显卡孱弱而建构的2D背景建模、3D人物动态的游戏一样。精美、动态和准确,三者达成了某种平衡。而未来的AI世界构建可能也需要在这三种技术路线中找到恰当的融合方式。\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e而这种融合不仅需要技术上的突破,更需要我们深入思考:什么才是\u0026#34;真实\u0026#34;的数字世界?是视觉上的真实,交互上的自然,还是空间上的精确?\u003c/p\u003e\u003cp\u003e\u003c/p\u003e\u003cp\u003e也许答案不在于非此即彼的选择,而在于如何让这些不同维度的\u0026#34;真实\u0026#34;和谐共存。毕竟,在追求构建数字宇宙的过程中,我们不仅在创造新的技术,也在重新定义什么是\u0026#34;真实\u0026#34;的世界。\u003c/p\u003e\u003cp data-exeditor-arbitrary-box="image-box"\u003e\u003c!--IMG_12--\u003e\u003c/p\u003e\u003cdiv data-exeditor-arbitrary-box="wrap"\u003e\u003cp\u003e\u003c/p\u003e\u003c/div\u003e\u003cdiv powered-by="qqnews_ex-editor"\u003e\u003c/div\u003e\u003cstyle\u003e.rich_media_content{--news-tabel-th-night-color: #444444;--news-font-day-color: #333;--news-font-night-color: #d9d9d9;--news-bottom-distance: 22px}.rich_media_content p:not([data-exeditor-arbitrary-box=image-box]){letter-spacing:.5px;line-height:30px;margin-bottom:var(--news-bottom-distance);word-wrap:break-word}.rich_media_content{color:var(--news-font-day-color);font-size:18px}@media(prefers-color-scheme:dark){body:not([data-weui-theme=light]) .rich_media_content p:not([data-exeditor-arbitrary-box=image-box]){letter-spacing:.5px;line-height:30px;margin-bottom:var(--news-bottom-distance);word-wrap:break-word}body:not([data-weui-theme=light]) .rich_media_content{color:var(--news-font-night-color)}}.data_color_scheme_dark .rich_media_content p:not([data-exeditor-arbitrary-box=image-box]){letter-spacing:.5px;line-height:30px;margin-bottom:var(--news-bottom-distance);word-wrap:break-word}.data_color_scheme_dark .rich_media_content{color:var(--news-font-night-color)}.data_color_scheme_dark .rich_media_content{font-size:18px}.rich_media_content p[data-exeditor-arbitrary-box=image-box]{margin-bottom:11px}.rich_media_content\u003ediv:not(.qnt-video),.rich_media_content\u003esection{margin-bottom:var(--news-bottom-distance)}.rich_media_content hr{margin-bottom:var(--news-bottom-distance)}.rich_media_content .link_list{margin:0;margin-top:20px;min-height:0!important}.rich_media_content blockquote{background:#f9f9f9;border-left:6px solid #ccc;margin:1.5em 10px;padding:.5em 10px}.rich_media_content blockquote p{margin-bottom:0!important}.data_color_scheme_dark .rich_media_content blockquote{background:#323232}@media(prefers-color-scheme:dark){body:not([data-weui-theme=light]) .rich_media_content blockquote{background:#323232}}.rich_media_content ol[data-ex-list]{--ol-start: 1;--ol-list-style-type: decimal;list-style-type:none;counter-reset:olCounter calc(var(--ol-start,1) - 1);position:relative}.rich_media_content ol[data-ex-list]\u003eli\u003e:first-child::before{content:counter(olCounter,var(--ol-list-style-type)) '. ';counter-increment:olCounter;font-variant-numeric:tabular-nums;display:inline-block}.rich_media_content ul[data-ex-list]{--ul-list-style-type: circle;list-style-type:none;position:relative}.rich_media_content ul[data-ex-list].nonUnicode-list-style-type\u003eli\u003e:first-child::before{content:var(--ul-list-style-type) ' ';font-variant-numeric:tabular-nums;display:inline-block;transform:scale(0.5)}.rich_media_content ul[data-ex-list].unicode-list-style-type\u003eli\u003e:first-child::before{content:var(--ul-list-style-type) ' ';font-variant-numeric:tabular-nums;display:inline-block;transform:scale(0.8)}.rich_media_content ol:not([data-ex-list]){padding-left:revert}.rich_media_content ul:not([data-ex-list]){padding-left:revert}.rich_media_content table{display:table;border-collapse:collapse;margin-bottom:var(--news-bottom-distance)}.rich_media_content table th,.rich_media_content table td{word-wrap:break-word;border:1px solid #ddd;white-space:nowrap;padding:2px 5px}.rich_media_content table th{font-weight:700;background-color:#f0f0f0;text-align:left}.rich_media_content table p{margin-bottom:0!important}.data_color_scheme_dark .rich_media_content table th{background:var(--news-tabel-th-night-color)}@media(prefers-color-scheme:dark){body:not([data-weui-theme=light]) .rich_media_content table th{background:var(--news-tabel-th-night-color)}}.rich_media_content .qqnews_image_desc,.rich_media_content p[type=om-image-desc]{line-height:20px!important;text-align:center!important;font-size:14px!important;color:#666!important}.rich_media_content div[data-exeditor-arbitrary-box=wrap]:not([data-exeditor-arbitrary-box-special-style]){max-width:100%}.rich_media_content .qqnews-content{--wmfont: 0;--wmcolor: transparent;font-size:var(--wmfont);color:var(--wmcolor);line-height:var(--wmfont)!important;margin-bottom:var(--wmfont)!important}.rich_media_content .qqnews_sign_emphasis{background:#f7f7f7}.rich_media_content .qqnews_sign_emphasis ol{word-wrap:break-word;border:none;color:#5c5c5c;line-height:28px;list-style:none;margin:14px 0 6px;padding:16px 15px 4px}.rich_media_content .qqnews_sign_emphasis p{margin-bottom:12px!important}.rich_media_content .qqnews_sign_emphasis ol\u003eli\u003ep{padding-left:30px}.rich_media_content .qqnews_sign_emphasis ol\u003eli{list-style:none}.rich_media_content .qqnews_sign_emphasis ol\u003eli\u003ep:first-child::before{margin-left:-30px;content:counter(olCounter,decimal) ''!important;counter-increment:olCounter!important;font-variant-numeric:tabular-nums!important;background:#37f;border-radius:2px;color:#fff;font-size:15px;font-style:normal;text-align:center;line-height:18px;width:18px;height:18px;margin-right:12px;position:relative;top:-1px}.data_color_scheme_dark .rich_media_content .qqnews_sign_emphasis{background:#262626}.data_color_scheme_dark .rich_media_content .qqnews_sign_emphasis ol\u003eli\u003ep{color:#a9a9a9}@media(prefers-color-scheme:dark){body:not([data-weui-theme=light]) .rich_media_content .qqnews_sign_emphasis{background:#262626}body:not([data-weui-theme=light]) .rich_media_content .qqnews_sign_emphasis ol\u003eli\u003ep{color:#a9a9a9}}.rich_media_content h1,.rich_media_content h2,.rich_media_content h3,.rich_media_content h4,.rich_media_content h5,.rich_media_content h6{margin-bottom:var(--news-bottom-distance);font-weight:700}.rich_media_content h1{font-size:20px}.rich_media_content h2,.rich_media_content h3{font-size:19px}.rich_media_content h4,.rich_media_content h5,.rich_media_content h6{font-size:18px}.rich_media_content li:empty{display:none}.rich_media_content ul,.rich_media_content ol{margin-bottom:var(--news-bottom-distance)}.rich_media_content div\u003ep:only-child{margin-bottom:0!important}.rich_media_content .cms-cke-widget-title-wrap p{margin-bottom:0!important}\u003c/style\u003e\u003c/div\u003e

本文来自作者[邹明璨]投稿,不代表蔚蓝之海立场,如若转载,请注明出处:https://foryh.cn/wiki/31912.html

评论列表(4条)

我是蔚蓝之海的签约作者“邹明璨”!

希望本篇文章《三大AI顶流,争着“造世界”_腾讯新闻》能对你有所帮助!

本站[蔚蓝之海]内容主要涵盖:生活百科,小常识等内容......

本文概览:#################################### \u003cdiv class="rich_media_content"\u003e\u003cp\u...